На заре проникновения информационных технологий во все сферы человеческой деятельности, когда про облака только-только начинали говорить, для хранения и обработки данных компании самостоятельно покупали ИТ-оборудование, размещали на нем инфраструктуру и обслуживали ее своими силами. Постепенно потребности в ресурсах увеличивались, и небольших локальных серверных перестало хватать для решения актуальных задач бизнеса. Так появились центры обработки данных.

Что такое центр обработки данных?

ЦОД — это здание (или комплекс зданий), предназначенное исключительно для размещения и эксплуатации ИТ-оборудования. Чтобы расположенное в нем «железо» работало 24/7, в дата-центрах созданы максимально благоприятные условия.

ЦОДы в определенной форме существуют еще с середины прошлого века. Тогда в дата-центре мог размещаться всего один компьютер (вспомните размеры первых вычислительных машин!), а компания не могла обратиться к его владельцу и просто так арендовать ресурсы этого компьютера. С течением времени размер оборудования уменьшался, а спрос на вычислительные мощности рос. Постепенно ЦОДы стали такими, какими мы знаем их сегодня.

Как мы строим ЦОДы

Ключевые компоненты инженерной инфраструктуры ЦОД

Надежность работы ИТ-оборудования зависит от множества условий — класс используемого «железа», соблюдение регламентов его технического обслуживания и даже квалификация сотрудников дата-центра. Однако одним из ключевых факторов является качество реализации инженерных систем. Выделяется пять наиболее важных систе:

- Энергоснабжение

Электричество — источник жизни всех систем и оборудования. Чтобы ЦОД всегда был обеспечен питанием, его подключают к электросети по нескольким вводам одновременно, а на случай проблем с питанием от города объект в обязательном порядке снабжают системами бесперебойного питания и ДГУ. - Охлаждение

Серверное оборудование в процессе функционирования выделяет большое количество тепла, а перегрев негативно влияет на его работоспособность и производительность. Поэтому помещение, в котором оно установлено, должно эффективно охлаждаться. Для этих целей в дата-центре используется специализированное оборудование — прецизионные кондиционеры и чиллеры. - Безопасность

Мало просто разместить оборудование, подключить его к различным источникам питания и отводить избыточное тепло. Необходимо обеспечить комплексную защиту дата-центра и всего, что находится внутри. Современный ЦОД Tier III оборудован всесторонними средствами защиты: различными системами пожаротушения (водяными, порошковыми, газовыми), средствами сверхраннего обнаружения возгораний, СКУД и другими. - Каналы передачи данных

Стабильная передача данных важна для дата-центра не менее, чем системы безопасности. Современный ЦОД подключен как к выделенным каналам связи, так и к общедоступным сетям с широкой полосой пропускания. Каналы в обязательном порядке резервируются — это закладывается еще на этапе проектирования ЦОД. - Диспетчеризация

Чтобы все вышеперечисленные системы работали без сбоев, необходимы продвинутые инструменты мониторинга и диспетчеризации. За всеми компонентами ЦОД ведется круглосуточное видеонаблюдение, а для устранения даже несущественных проблем существуют четкие регламенты и алгоритмы.

Кто работает в ЦОД? Ежедневный обход с дежурным инженером.

Какими бывают дата-центры

В зависимости от того, кем используется ЦОД, он может относится к одному из двух типов:

- Внутренние (корпоративные). К ним относятся дата-центры, которые используются одним предприятием для решения его задач. Компания-владелец получает полный контроль над всем комплексом и может использовать ресурсы дата-центра по своему усмотрению.

- Коммерческие. Этот тип ЦОД строят в целях дальнейшей продажи его услуг (аренда юнитов, стоек, модулей, размещение оборудования) и облачных сервисов. Арендовать ресурсы в коммерческом ЦОД может любая компания, у которой есть потребности в вычислительных мощностях.

Стандарты Tier

Дата-центры различаются не только по назначению, но и по уровню надежности. Согласно классификации Uptime Institute, существует четыре уровня ЦОД — от Tier I до Tier III. Давайте посмотрим, чем эти уровни отличаются друг от друга.

- Tier I — инфраструктура начального уровня без резервирования. К этому уровню относятся самые слабые и ненадежные дата-центры. Фактически, этот класс ЦОД ушел в небытие — последний сертификат Tier I был выдан более полувека назад. В таком дата-центре напрочь отсутствует резервирование, а бесперебойное питание является необязательным к исполнению требованием.

- Tier II — инфраструктура с резервированием. В Tier II ЦОДах активное оборудование зарезервировано по схеме N+1. Требуется наличие фальшпола, а энергоснабжение и охлаждение ЦОД должно соответствовать определенным параметрам.

- Tier III — инфраструктура c возможностью параллельного технического обслуживания. Наиболее распространенный и популярный уровень ЦОД на сегодняшний день. Профилактические и ремонтные работы в Tier III дата-центрах (в отличие от ЦОДов предыдущих уровней) можно проводить без остановки его работы. Гарантированная доступность составляет 99.982%

- Tier IV — инфраструктура с максимальной отказоустойчивостью. Наивысший уровень надежности ЦОД. Активное оборудование резервируется по схеме 2(N+1), а надежность составляет 99.995%. Однако строительство такого ЦОД требует колоссальных затрат, что непременно отражается на стоимости услуг дата-центра. К тому же дата-центры Tier IV крайне мало распространены, а их зарезервированность часто бывает избыточной даже для бизнеса, чья прибыль напрямую зависит от работы ИТ-систем.

Плюсы использования ЦОД

У аренды услуг ЦОД есть немало преимуществ. Давайте разберемся, что получает заказчик, пользующийся возможностями коммерческого дата-центра.

- Надежность

Далеко не у всех компаний есть ресурсы и компетенции, чтобы обеспечить такой же уровень надежности работы ИТ-оборудования, как в дата-центре. В коммерческих ЦОД зарезервированы все ключевые системы, гарантируется бесперебойное энергоснабжение, охлаждение и работа каналов связи. Кроме того, уровень доступности сервисов и обязательства провайдера услуг фиксируются в соглашении с финансовой ответственностью. - Сокращение расходов

ИТ-аутсорсинг позволяет снизить непрофильные издержки на ИТ: возможность арендовать услуги ЦОД снимает с компании затраты, связанные с строительством собственного дата-центра, его обслуживанием и обеспечением бесперебойной работы всех систем. - Масштабируемость

Размещая инфраструктуру в собственной серверной, компании нередко попадают в ловушку. Бизнес растет, потребности в ИТ-ресурсах увеличиваются, а дальнейшее расширение помещения с каждым разом становится все более затруднительным. Клиенты дата-центра с такой проблемой не сталкиваются: в коммерческом ЦОДе всегда найдутся ресурсы для масштабирования ИТ-инфраструктуры.

Сегодня благодаря развитию ИТ-отрасли любая компания может арендовать не только непосредственно услуги ЦОД (размещение оборудования, аренду юнитов, стоек и модулей), но и готовые облачные сервисы, развернутые на базе выбранного дата-центра.

Источник: cloud.mts.ru

Что такое цод в строительстве

Необходимость создать эффективный ЦОД возникает тогда, когда у предприятия возникает реальная потребность в бесперебойности, управляемости и масштабируемости, когда от ИТ-инфраструктуры зависит стабильность бизнеса в целом. Принципиальным отличием ЦОД от серверной комнаты является его комплексное оснащение всем спектром инженерных систем и применение специальных мер по обеспечению работы информационной инфраструктуры предприятия в том режиме, который необходим бизнесу.

ЦОД расшифровывается как центр обработки данных, синонимами термина в специализированной литературе являются названия дата-центр или ЦХОД — центр хранения и обработки данных. Из самого названия следует, что в ЦОД производятся операции, связанные с обработкой информации. Обработка подразумевает создание или генерирование информации, последующее архивирование и хранение, предоставление информации по запросу, и, наконец, ее безопасное уничтожение. Помимо обработки, необходима защита информации на всех стадиях жизненного цикла. Связано это с тем, что, во-первых, информация становится необходимым активом бизнеса и приобретает самостоятельную ценность, во-вторых, современное законодательство предъявляет к субъектам экономики ряд серьезных требований по защите персональной информации, что обязывает компании применять технические и программные меры по ее защите от утечек, несанкционированного доступа и потери.

По своей сути информация может носить совершенно разный характер. Например, есть информация, которая нацелена на обеспечение бизнеса или процесса. Так, для выполнения банковских операций, связанных со снятием денежных средств, необходимы данные о количестве средств на счете владельца.

Существуют фонды информации — пенсионный фонд РФ, кадастры земли, различные библиотеки и т.д. — они выполняют задачи сбора и хранения информации. Существует информация, которая сама генерирует бизнес, например, информация, которую используют различные справочные службы.

Есть информация, которая не участвует в бизнес-процессах, но необходима для их осуществления, например, базы данных кадровых служб и базы данных учетных записей пользователей информационных систем. Промышленные холдинги используют данные для выполнения расчетных задач, создают электронные архивы для хранения документации, автоматизируют бизнес-процессы. Таким образом, у разных компаний и организаций сосуществуют разные виды информации и задачи, связанные с ее обработкой. Для решения этих задач и создаются ЦОД.

Когда нужен ЦОД?

Задачи обработки информации решались в разное время при помощи разных технических средств. В ХХ веке электронно-вычислительные устройства взяли на себя выполнение больших вычислительных задач, а появление устройств для хранения информации позволило перейти от бумажных архивов к более компактным и доступным ленточным и электронным носителям.

Уже для размещения первых ЭВМ требовалось создание специальных помещений — машинных залов, в которых поддерживались определенные климатические условия, чтобы предотвратить перегрев оборудования и обеспечить его стабильную работу. С началом эпохи персональных компьютеров и компактных серверов вычислительное оборудование компаний сосредоточилось в серверных комнатах. В большинстве случаев под серверной комнатой на предприятии понимается отдельное помещение, оснащенное бытовым кондиционером и источником бесперебойного питания (ИБП), которые создают минимальные условия для непрерывной работы техники. Однако сегодня это годится только для тех предприятий, бизнес-процессы которых незначительно зависят от вычислительных ресурсов и информации.

«По большому счету, центр обработки данных является увеличенной копией серверной комнаты. У них много общего: эти помещения должны быть оборудованы инженерными системами, позволяющими поддерживать непрерывность работы вычислительного оборудования предприятия, обеспечивать требуемый микроклимат и должный уровень безопасности, — считает Алексей Трояновский, технический директор компании «Черус». — Но есть и ряд принципиальных отличий. Как только бизнес-информация становится ключевым фактором работоспособности предприятия и надежность работы корпоративной информационной инфраструктуры определяет непрерывность всех бизнес-процессов, требуются другие, более надежные решения, подразумевающие гарантированное энергоснабжение (дизель-генераторные установки); бесперебойное энергоснабжение (ИБП); прецизионное кондиционирование; комплексную систему безопасности (газовое пожаротушение; охранно-пожарная сигнализация; контроль доступа и видеонаблюдение), автоматизированную систему диспетчеризации и контроля работы оборудования».

Итак, необходимость создать и поддерживать эффективный ЦОД возникает тогда, когда у предприятия появляется реальная потребность в бесперебойности, управляемости и масштабируемости, когда от ИТ-инфраструктуры зависит стабильность бизнеса в целом. Принципиальным отличием ЦОД от серверной комнаты является его комплексное оснащение всем спектром инженерных систем и применение специальных мер по обеспечению работы информационной инфраструктуры предприятия в том режиме, который необходим бизнесу.

Кому нужен ЦОД?

В России первые ЦОД стали появляться в 2000-м году. Их заказчиками были банковские структуры, предприятия нефтяной отрасли и государственные органы. Еще в 1999-м году заработал первый опытный российский ЦОД при одной из налоговых инспекций, который обрабатывал декларации и справки о доходах жителей Москвы и Московской области.

Одним из первых крупных российских ЦОД был центр «Сбербанка». В 2003-м году при поддержке «Ростелекома» в Чувашии открылся первый в России республиканский центр обработки данных, который использовался для систематизации архивных данных, обеспечивал органы местной власти, а в 2006-м был открыт ЦОД при научном центре «Курчатовский институт» (РНЦ КИ). В 2007-м запущены в эксплуатацию ЦОД компаний Yandex и ВТБ-24.

Сегодня собственный ЦОД нужен большинству крупных территориально-распределенных компаний, в которых существует высокая зависимость бизнеса от организации ИТ. Примерами могут служить многофилиальные банки, операторы связи, компании-ритейлеры, транспортные и туристические компании, промышленные холдинги, медицинские учреждения, государственные организации и т.д.

ЦОД может быть предназначен как для использования одним предприятием, так и являться многопользовательским. Многопользовательский ЦОД предоставляет широкий спектр услуг, среди которых business continuity а также общая офисная зона и складские помещения.

К проектированию перечисленных помещений следует отнестись с особым вниманием: некоторые из них рекомендуется размещать в комнатах, не имеющих наружных стен (машинный зал), другие — на территории, предполагающей возможность масштабирования. В дата-центре существуют также «несовместимые» помещения. Хорошим примером могут служить машинный зал и помещения, генерирующие пыль (склад, принтерная). Помимо того, что эти помещения необходимо размещать в раздельных комнатах, в них должны быть установлены раздельные системы кондиционирования и вентиляции.

Внимательно нужно отнестись к проектированию высоты (не менее 2,6 м) и ширины (не менее 1,5 м) дверей, не забыв прибавить к высоте дельту от фальшпола. Предусмотрительность здесь также связана с ввозом оборудования в помещение дата-центра. Чтобы повысить уровень безопасности ЦОД, можно разместить оборудование систем электропитания, кондиционирования и т.д. за пределами машинного зала. Таким образом, сотрудники, обслуживающие оборудование, не будут иметь туда доступа.

В-третьих, системы бесперебойного гарантированного энергоснабжения — надежность дата-центра напрямую зависит от степени резервирования системы электроснабжения. Если не обеспечить резервирования источников общего энергоснабжения, ИБП и проводов заземления, то при любом плановом ремонте и, тем более, отказах оборудования, работа по обработке данных будет прервана до момента восстановления систем.

Наиболее высокий уровень безопасности предусматривает одновременную работу по меньшей мере 2-х путей распределения, как правило в конфигурации «Система+Система». С точки зрения электрооборудования это означает наличие двух отдельных систем ИБП, в которых каждая система предполагает резервирование каждого ее модуля.

В-четвертых, телекоммуникации — для повышения надежности необходимо резервировать комнаты ввода кабелей от сетей общего доступа, размещая их в разных огнезащитных зонах. Комнаты не должны иметь общих распределительных щитов питания и общего оборудования для кондиционирования воздуха.

Существенно повышает надежность дата-центра подключение его сразу к двум провайдерам. При этом офисы поставщиков услуг должны находиться в разных зданиях и кабельные трассы к ним должны пролегать по разным маршрутам. Наличие нескольких провайдеров является обычной практикой и обеспечивает непрерывность связи в случае банкротства одного из них или масштабной аварии, затрагивающей его системы.

В-пятых, системы вентиляции и кондиционирования в дата-центре отвечюет за климатические условия (температуру, влажность) и включают в себя меры по отводу тепла и влаги из помещения. Вычислительному оборудованию дата-центра следует обеспечить оптимальный режим отвода выделяемого в процессе работы тепла, иначе оно может перегреться и выйти из строя. Для решения данной задачи в дата-центре внедряется система технологического кондиционирования.

Уровень системы кондиционирования напрямую зависит от задач, поставленных перед дата-центром. Если ЦОД необходимо выполнять большой объем операций по обработке информации, то мощное оборудование, установленное в дата-центре, будет выделять много тепла, и, система охлаждения должна быть спроектирована с учетом этих параметров.

Как показывает практика, система холодоснабжения представляет собой самую критичную составляющую комплекса ЦОД: перерыв в ее работе всего на 30 минут может повлечь за собой выход из строя оборудования, обеспечивающего функционирование ЦОД, поэтому необходимо проектировать, строить и эксплуатировать ее максимально профессионально и ответственно.

Самый лучший гарант надежности — это резервирование, которое для системы холодоснабжения может выполняться по схеме N+1 (система, состоящая из (N+1) модулей, один из которых (любой) является избыточным) или 2N (100-процентное резервирование системы).

Резервирование системы по схеме N+1

Резервирование системы по схеме 2N

Независимо от уровня надежности дата-центра следует уделить особое внимание поддержанию в помещении ЦОД необходимой влажности. Эта задача также ложится на плечи системы кондиционирования. Сухой воздух опасен для серверных помещений, т.к. при понижении влажности повышается электростатический потенциал, что может быть причиной выхода из строя оборудования. Нормой для ЦОД считается влажность в пределах 40-50%.

Существуют серверы, не очень требовательные к влажности. Для них допустимые параметры составляют от 10 до 90% относительной влажности воздуха (например, серверы таких производителей, как HP, Cisco). Но вот компания Sun Microsystems может снять технику с гарантии при условии, что влажность воздуха выходит за пределы 40-60%.

В-шестых, система водоснабжения и водоотвода — является неотъемлемой частью дата-центра, так как вода необходима для увлажнения помещений и охлаждения техники в ЦОД. В то же время оборудование необходимо защищать от возможных протечек, т.к. в результате контакта с водой оно может выйти из строя. Поэтому в высоконадежном отказоустойчивом дата-центре через его помещения и над ними не должны проходить водопроводные или канализационные трубы, не связанные с оборудованием дата-центра. Водопроводные пути, поддерживающие оборудование дата-центра, следует заключить в кожухи или специальные защитные оболочки от протечек.

Все процессы, связанные с влагой, нужно обязательно контролировать. Для контроля протечек в помещении дата-центра необходимо установить систему технических сигнализаций, представляющих собой набор датчиков, которые устанавливаются в районах расположения потенциальных источников влаги и срабатывают в случае, если на них попадает вода.

Комплексная система безопасности дата-центра, как и любая другая, состоит из трех подсистем:

- Система контроля доступа;

- Система охранной сигнализации;

- Система пожарной сигнализации и пожаротушения.

Защита дата-центра от несанкционированного доступа является одной из первоочередных задач. Часть ответственности в данном случае ложится на архитектуру ЦОД: наиболее критичные помещения должны находиться в зоне ограниченного доступа. Неотъемлемой частью защиты ЦОД являются системы видеонаблюдения и охранной сигнализации. Системы биометрического контроля внедряются в России пока не очень активно, так как достаточно дороги и не обеспечивают требуемой надежности.

Минимальные требования к системе пожаротушения включают в себя наличие спринклерной системы и огнетушителей, не загрязняющих оборудование. Проектировать спринклерную систему надо так, чтобы вода при разбрызгивании не заливала дорогостоящее оборудование.

В дата-центрах более высокого уровня обычно устанавливается система автоматического газового пожаротушения и звуковой сигнализации. Газ не вредит работе оборудования, но очень опасен для человека, поэтому эти системы проектируются с учетом времени эвакуации персонала и совмещены с дополнительными мерами по оповещению персонала и контролю за эвакуацией. Пожарная сигнализация в обязательном порядке должна быть интегрирована со схемой управления системой охлаждения, чтобы в случае необходимости произвести аварийное отключение кондиционирующего оборудования.

«Несмотря на высокую надежность систем кондиционирования и охлаждения, есть риск мелких неисправностей и поломок, которые могут оказать негативное влияние на работу центра обработки данных. Поэтому для защиты сетей и систем от подобных физических угроз необходимо использовать средства мониторинга состояния физической среды, — говорит Андрей Воробьев. — Они позволяют отслеживать визуально фиксируемые события и параметры окружающей среды, включая температуру, влажность, движения воздуха и т.д. А также собирать данные с видеокамер и датчиков, реагируя на приказы в соответствии с заданными пользователем действиями и сигналами тревоги».

Система мониторинга и диспетчерского управления существенно повышает уровень надежности дата-центра, т.к. позволяет упреждать сбои в работе его систем. В задачи АСДУ входит локальный и дистанционный контроль механического, электрического и другого оборудования. Система позволяет обеспечить безаварийную работу ЦОД и сократить эксплуатационные расходы.

«Необходимость АСДУ хорошо иллюстрирует пример, когда компания, сэкономив на АСДУ, не получила своевременно сигнал о севшем аккумуляторе в ИБП, соответственно, при отключении энергоснабжения, резервный ИБП не завелся. Работа ЦОД была остановлена на 2 часа до момента выяснения причин и устранения неисправности. Прямые убытки компании за 2 часа составили несколько сотен тысяч у.е., плюс репутационные потери», — отмечает Владимир Лонгинов, руководитель направления компании «Черус».

Катастрофоустойчивые ЦОД

Если надежность направлена на защиту дата-центра от собственных поломок, то под катастрофоустойчивостью ЦОД понимается способность выдерживать те или иные катаклизмы и воздействия внешней среды: пожары, затопления, воздействие вредных газов, землетрясения, наводнения, удары молний, военные действия и т.д. Требования катастрофоустойчивости регламентируются такими параметрами как шкала бальности землетрясений, молниезащита, мощность взрывной волны и т.д., поэтому понятия надежности и катастрофоустойчивости не тождественны друг другу (хотя некоторыми специалистами эти понятия не разделяются). Понятно, что можно создать надежный, работающий в режиме 24/7/365 ЦОД, но он не будет при этом катастрофоустойчивым. И наоборот — катастрофоустойчивым может быть ЦОД не самого высокого уровня надежности.

«Сегодня руководство большинства компаний в России выделяет достаточно серьезные средства на развитие структуры ИТ, а также на техническую и логическую безопасность. Но при этом зачастую физическая безопасность ИТ-ресурса остается вне поля зрения и не финансируется в достаточной мере. Такая ситуация не может длиться долго», — считает Станислав Заржецкий, директор Lampertz Россия. «Общеизвестно, что существует как минимум семь основных факторов риска потери информации от физического воздействия: огонь, вода, дым и коррозийные газы, взрыв, обрушение (падающие обломки), несанкционированный доступ, вандализм. Отсутствие должного внимания к защите от такого рода воздействий ставит под угрозу существование и работу всей ИТ-структуры компании, что, в свою очередь, грозит потерей инвестиций, престижа и средств, вплоть до полного банкротства».

Какие технические меры позволяют говорить о катастрофоустойчивости ЦОД? Требования к ЦОД по катастрофоустойчивости, как и требования надежности, необходимо закладывать на стадии подготовки задания на проектирование ЦОД, т.к. это требует применения специальных технических средств при строительстве ЦОД.

Например, если необходимо обеспечить устойчивость ЦОД к землетрясениям, проектировщики предусматривают специальную систему крепления оборудования в ЦОД, которая позволяет выдерживать подземные толчки без разрушения оборудования, кабельной сети и т.д. Для защиты от ударов молний, высокой температуры, наводнений используются специальные герметичные комнаты, в которых размещаются все системы и экранируется электромагнитное излучение. Катастрофоустойчивость также подразумевает способность работы ЦОД без обслуживающего персонала и управление всеми системами в удаленном режиме. Но, пожалуй, единственным решением для достижения полной катастрофоустойчивости является территориальное резервирование ЦОД. При этом необходимо реализовать схему, по которой основной и резервный ЦОДы будут обмениваться информацией и синхронизировать происходящие изменения.

Руслан Заединов, руководитель направления центров обработки данных компании «Крок»:

Собственный ЦОД, действительно, стал насущной необходимостью для любой крупной компании. Стимулом к его созданию может послужить рост бизнеса, консолидация активов, переход на новые технологии обработки информации, а также необходимость соответствия тем или иным нормам.

К самому ЦОД предъявляются те же требования по отказоустойчивости и возможности безостановочного обслуживания, что и к информационным системам, которые в нем размещаются. Это приводит к необходимости резервирования всех подсистем жизнеобеспечения ЦОД и накладывает дополнительные требования на помещение для ЦОД.

Поэтому при проектировании ЦОД наряду с резервированием нужно обеспечить и возможность масштабирования инженерных систем. Вычислительные мощности серверных систем увеличиваются с нарастающей быстротой, а вместе с ними растут энергопотребление и тепловыделение.

И если компании склонны менять серверный парк довольно часто, чтобы соответствовать современным требованиям по производительности, то вложения в инженерные системы являются долгосрочными. Поэтому важно избежать ошибки применения в масштабируемом ЦОД немасштабируемого решения для систем кондиционирования, бесперебойного питания, СКС, других инженерных системах ЦОД. Проблему масштабируемости можно решить установкой инженерных систем максимальной мощности еще на этапе создания ЦОД. Очевидно, что такой подход неэффективен с экономической точки зрения. Поэтому предпочтителен вариант модульной реализации инженерных систем с возможностью наращивания их мощности путем добавления новых модулей без замены уже установленного оборудования.

Однако можно подойти к обеспечению масштабируемости инженерных систем с другой стороны. Более глубокий подход к обеспечению масштабируемости обеспечивающих систем ЦОД состоит в применении вычислительных комплексов с выделением ресурсов on demand или «по требованию». В этом случае вычислительные мощности выделяются динамически пропорционально задаче.

Это позволяет, например, приобрести в настоящее время серверный комплекс относительно малой вычислительной мощности и постепенно наращивать мощность, не добавляя новые процессоры и память. Причем, наращивание вычислительных мощностей будет происходить с максимальным соответствием с растущими требованиями бизнеса.

Более того, можно будет перераспределять процессорные мощности между задачами в зависимости от текущей необходимости. Все это в совокупности приведет к незначительному росту требований к инженерным системам при значительном росте возможностей серверного комплекса в будущем. Ярким примером серверов, которые реализуют описанные функции, являются мэйнфреймы. Технологии on demand в них давно используются и являются, по сути, встроенными в них на аппаратном уровне. Учитывая еще и простоту эксплуатации мэйнфреймов, а также наличие для них полного спектра прикладных систем для автоматизации всех аспектов бизнеса, они завоевывают все большую популярность в качестве платформы для построения масштабируемого ЦОД.

Источник: www.cnews.ru

Что такое цод в строительстве

Активный рост компании и информации, с которой она работает, предполагает увеличение IT-мощностей и дискового пространства. Системы хранения данных, вычислительные мощности консолидируются и трансформируются в центры обработки данных, или ЦОДы.

Что такое ЦОД?

Дата-центр, центр обработки данных, или ЦОД — это отдельное помещение или даже целое здание, где размещено сетевое и серверное оборудование компании, и созданы специальные условия для бесперебойной и безопасной работы оборудования.

ЦОД: что внутри?

В дата-центре находится основная часть ИТ-инфраструктуры компании:

- Серверы, вычислительные ресурсы.

- Основные и резервные хранилища информации.

- Сетевое оборудование: от коммутаторов до контроллеров.

А также в состав ЦОД входят элементы, отвечающие за обеспечение корректной работы оборудования:

- Системы электроснабжения и резервные генераторы. Отвечают за бесперебойность работы инфраструктуры в случае проблем с подачей электричества.

- Системы охлаждения. Непрерывно работающее оборудование вырабатывает колоссальное количество тепла, которое нужно отводить, чтобы не допустить перегрева. Эти функции выполняют специальные кондиционеры и системы вентиляции.

- Противопожарная система. Так как в ЦОДе размещено дорогостоящее оборудование, от работы которого часто зависит прибыль компании, к противопожарным системам есть 2 требования: устранить пожар быстро и не повредить в процессе тушения оборудование. Поэтому привычные устройства, подающие воду или пену, не подходят — нужно специальное устройство, выпускающее газ, который вытесняет кислород и останавливает пожар.

- Системы защиты помещения от злоумышленников.

Как происходит строительство цод?

Строительство ЦОД — это комплекс мероприятий, преследующих цели:

- обеспечение максимальной надежности и доступности вычислительных ресурсов;

- эффективное энергопотребление;

- снижение затрат на обслуживание ИТ и инженерной инфраструктуры;

- снижение рисков финансовых убытков, связанных с простоями ЦОД.

Проектирование и строительство ЦОД — это целая индустрия со сформировавшимися стандартами и нормативами.

Перед строительством ЦОД необходимо провести большую подготовительную работу, поскольку недостаточное внимание к какому-либо из аспектов (расположение ЦОД, охлаждение, вентиляция, кабельная система, планировка помещения и расположение оборудования, фальшпол, контроль среды, питание, противопожарные системы, системы безопасности) может свести на нет эффективность остальных элементов проекта.

При выборе площадки для ЦОД необходимо учитывать:

- природные риски;

- физические риски;

- предоставляемые услуги и концентрация потребителей;

- планируемый рост;

- окружающая инфраструктура;

- доступность ресурсов (электроснабжение, газ, вода, качество воздуха, телекоммуникации).

Процесс разработки и проектирования ЦОД начинается с опроса заказчика и выявления его общих потребностей. На этом этапе собирается информация:

- планируемое увеличение ИТ-нагрузки за время эксплуатации ЦОД;

- возможность ввода дополнительных машинных залов;

- требования к отказоустойчивости инженерных систем (например, N+1 или 2N);

- требования к отказоустойчивости систем телекоммуникаций;

- реализуемые технологии;

- предполагаемые коэффициенты энергоэффективности.

Этап проектирования включает следующие процедуры:

- Архитектурный анализ помещения или здания.

- Финальная проверка ИТ-требований.

- Утверждение задание на проектирование.

- Разработка плана ввода в эксплуатацию.

- Согласование ИТ-инфраструктуры и архитектуры сети.

Важными элементами проекта являются размер помещений и их форма, нагрузка на пол, огнеупорность, входы и выходы, несущая способность подвесной системы. Площадь машинного зала должна быть определена на основании потребностей бизнеса и учитывать будущий рост. Помещение должно быть правильной формы для эффективного использования площади и распределения воздушных потоков.

Сейчас популярны контейнерные (модульные) ЦОД. Они оснащены специально разработанными стойками и системой водяного охлаждения. Преимуществом таких микро-ЦОД является повышенная энергоэффективность, за счет большей плотности размещения оборудования, а для ввода в эксплуатацию требуется подключить электропитание, воду для охлаждения и коммуникации.

Дата-центр: уровни

Организация Uptime Institute, осуществляющая сертификацию центров обработки данных, разработала классификацию уровней надежности ЦОД. Каждому уровню соответствует определенное допустимое время простоя в год:

Уровень 1 (Tier 1)

Инфраструктура без резервирования — для маленьких компаний с небольшим парком техники. ЦОД, в таком случае, предназначен для обслуживания базовых офисных задач. Допустимое время простоя: 28.8 часов в год. Это время обычно тратится на техническое обслуживание ЦОДа.

Уровень 2 (Tier 2)

Инфраструктура с дублированием критичных элементов — отличается от первого уровня наличием резервных мощностей. Может простаивать до 22 часов в год.

Уровень 3 (Tier 3)

Инфраструктура с резервированием N+1, позволяющая выполнять ремонт без остановки всей системы. Не более 1,6 часов простоя в год.

Уровень 4 (Tier 4)

Полностью отказоустойчивая (2N+1) инфраструктура, допускающая параллельный ремонт. Дата-центр такого уровня оснащен всеми резервными каналами, предусматривающими буквально любую ситуацию. Считается, что такой ЦОД должен работать, не останавливаясь, однако допускается 23,6 минут простоя в год.

Источник: xnet.com.ru

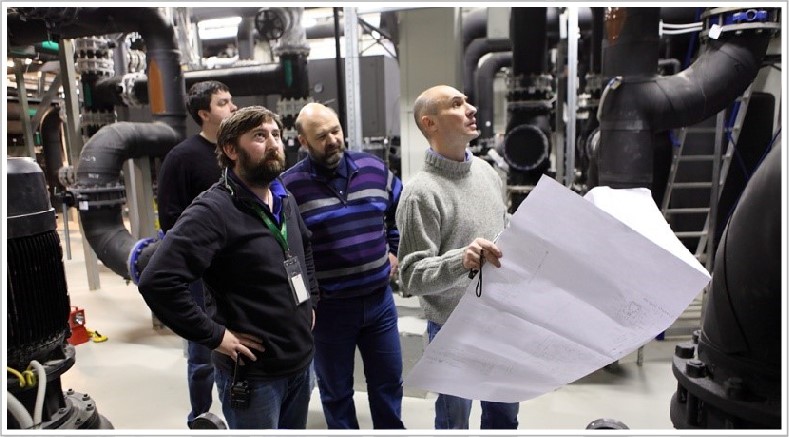

ЦОД для технопарка: от «бетона» до сертификации Tier Facility

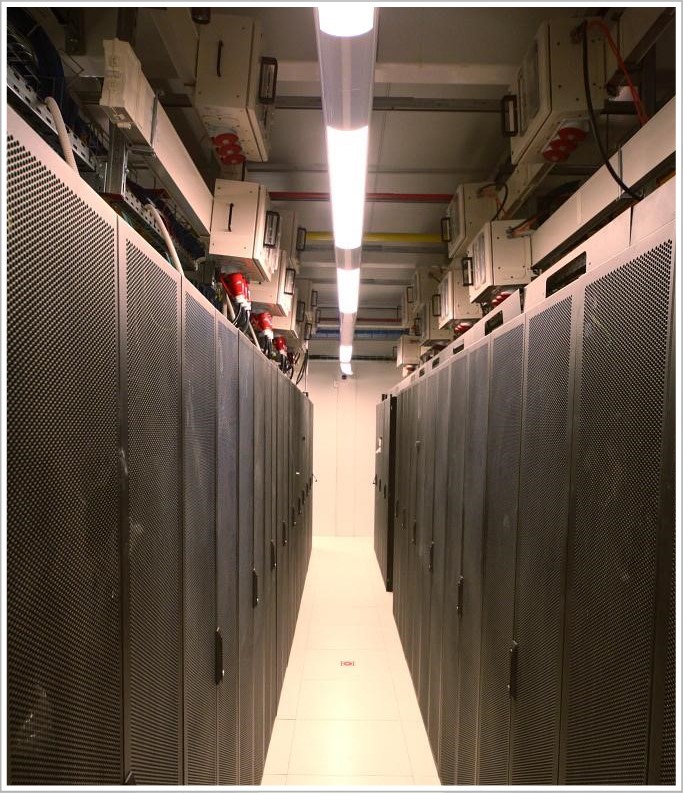

При строительстве центра технического обеспечения одного из крупнейших российских технопарков я отвечал за инженерную инфраструктуру. Объект седьмым в России прошел сертификацию Tier Facility авторитетного международного института Uptime Institute. О том, чего нам это стоило, какие решения мы использовали и как проходили испытания ЦОД на соответствие международным стандартам, я и расскажу в этом фотопосте.

Центр технического обеспечения (ЦТО) технопарка «Жигулевская долина» представляет собой двухэтажное здание. Оно включает шесть машинных залов общей площадью 843 кв. м и вмещает 326 стоек средней мощностью 7 кВт каждая (максимальная нагрузка на стойку – 20 кВт). А мы, специалисты компании «ЛАНИТ-Интеграция», впервые увидели его еще на стадии бетонного каркаса. На тот момент оно не имело никаких коммуникаций. Нам предстояло создать всю инженерную и сетевую инфраструктуру, а также часть вычислительной инфраструктуры для работы автоматики инженерных систем.

Для начала я немного расскажу о проекте в целом, а затем уже покажу всю «начинку».

Итак, в центре технического обеспечения «Жигулевской долины» нужно было установить серверы, СХД и другое оборудование, необходимое резидентам центра инноваций Самарской области. Конечно, для такого оборудования нужны специальные условия эксплуатации: энергообеспечение, тепловой режим, уровень влажности и т. д., поэтому экономически целесообразно было установить оборудование в одном месте.

Мы обследовали здание, изучили имеющуюся у заказчика документацию и приступили к разработке проектной документации (которой предстояло пройти государственную экспертизу). Самая большая сложность заключалась в том, что на разработку проектной и рабочей документации нам отвели всего три месяца. Параллельно с рабочей документацией приходилось готовить часть документации на английском языке для прохождения экспертизы международного института Uptime Institute.

В рамках проекта мы должны были:

- сделать ЦОД энергоэффективным;

- построить в сжатые сроки;

- выдержать экзамен Uptime Institute и получить сертификат Tier III.

Поскольку плотность инженерных систем в ЦОД очень высокая, а сроки сжатые, пришлось детально планировать работы, поставки материалов и оборудования.

Опять же из-за «горящих» сроков решили использовать высокотехнологичные быстровозводимые модульные конструкции – с их помощью избежали дополнительных строительных работ, не делали огнеупорные перегородки и мощную гидроизоляцию. Такое решение защищает помещение от воды, огня, пыли и других опасных для ИТ-оборудования факторов, при этом сборка модульной конструкции занимает всего 1-2 недели.

После экспертизы проекта стали разрабатывать рабочую документацию и заказывать оборудование. Кстати, об оборудовании: поскольку проект попал на кризисный год и возникли сложности с финансированием, нам пришлось всю работу подстраивать под финансовый план и прежде всего остального закупать дорогое крупногабаритное оборудование – цена на него была закреплена производителем.

Изменения в планах поставки оборудования потребовали еще более тщательного планирования. Чтобы организовать работу 100-150 человек на объекте без простоев, проектная команда много внимания уделяла процедурам управления изменениями и управления рисками. Ставку сделали на коммуникации: любая информация о проблемах и задержках практически сразу передавалась по всей цепочке от бригадиров – руководителю проекта и инженерам в головном офисе компании.

Проектная команда и менеджеры закупки трудились в Москве, а основная команда работала непосредственно в технопарке. Инженерам не раз приходилось выезжать в командировку на объект для уточнений и коректировки проектных решенией, а между тем от нашего московского офиса до технопарка по трассе почти 1000 км. Непосредственно на месте мы организовали строительный штаб – там регулярно проходили совещания с участием заказчика и руководителей работ, после которых вся обновленная текущая информация передавалась инженерной команде.

Большинство рабочих специальностей мы набирали в регионе (до 150 человек), что касается узких специалистов и инженеров, их пришлось направить в длительную командировку из Москвы.

В итоге всё получилось. Рассказ о главном испытании – сертификации Uptime Institute – я приберег на самый конец. А сейчас давайте посмотрим, как у нас всё устроено.

Чтобы попасть в ЦОД, необходимо иметь RFID пропуск и пройти идентификацию на входе на территорию ЦОДа. В здании также все двери под контролем, в некоторые залы действует допуск только после двойной идентификации сотрудника.

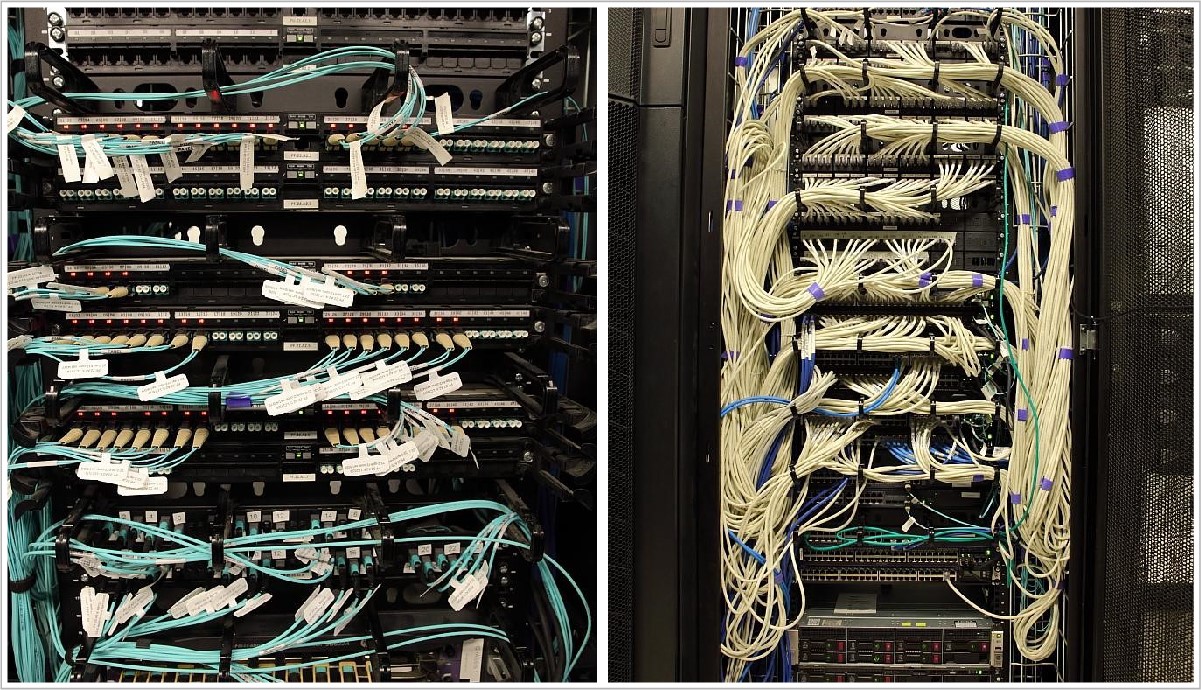

Структурированные кабельные системы

Для сети передачи данных мы использовали коммутаторы HP FlexFabric и Juniper QFabric. Интеллектуальная СКС Panduit с системой управления физической инфраструктурой PanView iQ позволяет удаленно контролировать и автоматически документировать состояние физического уровня сети, а также осуществлять интеллектуальное управление полем коммутации.

Возможно контролировать правильность подключения оборудования или нештатного подключения к портам СКС. Претерминированные кабели позволяют при необходимости менять конфигурацию СКС на тех участках, где это требуется.

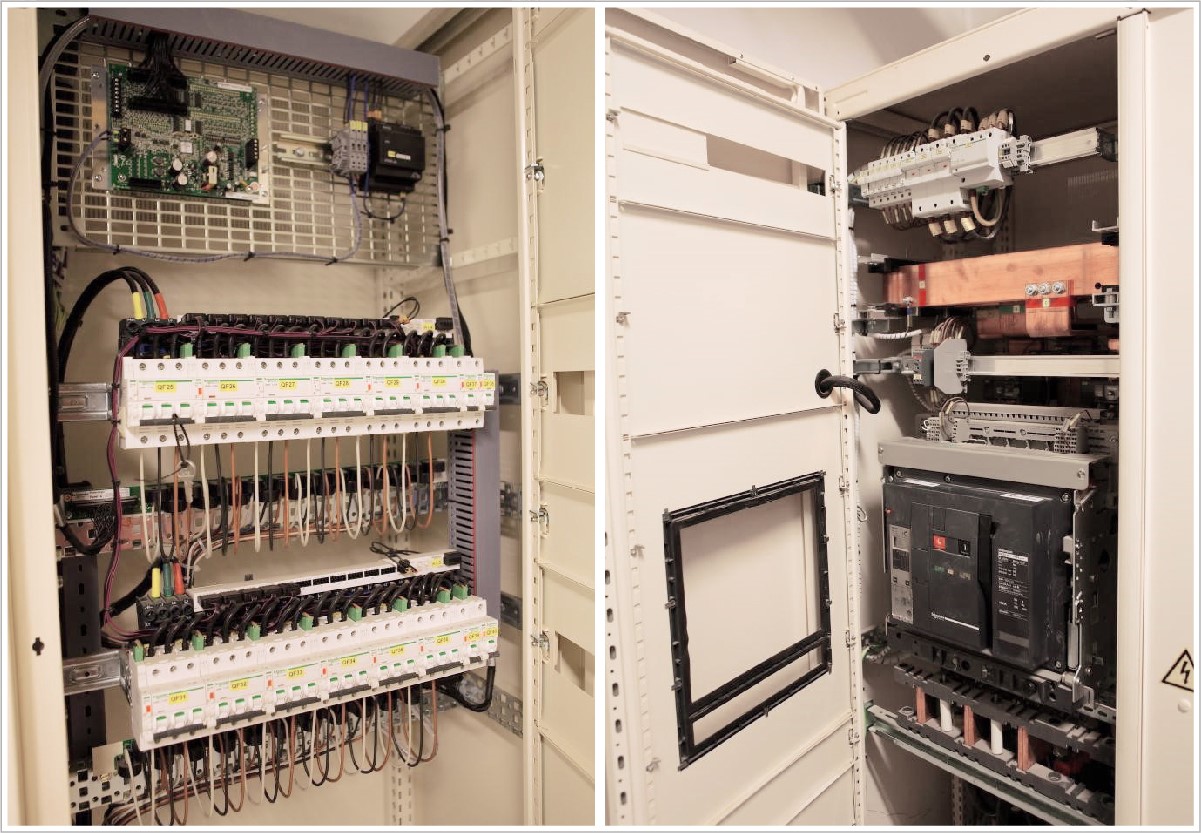

Электроснабжение ЦОД

В собственной трансформаторной подстанции станции ЦТО установлено 4 независимых трансформатора, которые питают электроэнергией вводно-распределительные устройства (ВРУ1-4) ЦТО.

Суммарная выделенная мощность на ЦОД – 4,7 МВт.

От трансформаторной подстанции в ВРУ ЦТО отходят 8 независимых лучей и через систему гарантированного питания на базе дизельно-роторных источников бесперебойного питания (ДДИБП) питают 8 ВРУ ЦОД, 4 ВРУ системы бесперебойного питания и 4 ВРУ системы гарантированного питания. Система питания построена по схеме 2N, кабели заходят с двух разных сторон здания ЦОД в две разнесенные электрощитовые.

Схема 2N реализует резервирование по электроснабжению. Любой питающий луч для обслуживания может быть выведен из работы, при этом ЦОД будет полностью работоспособен.

Для бесперебойного и гарантированного электроснабжения мы установили дизель-динамические источники бесперебойного питания Piller. Мощность каждого 1МВт бесперебойного и 650 кВт гарантированного питания, что позволяет обеспечить работу ЦОД в полном объеме.

В случае прекращения поступления электроэнергии ротор вращается по инерции и электрическая установка продолжает вырабатывать ток еще несколько секунд. Этого небольшого промежутка времени хватает на запуск дизель-генератора и выхода на рабочие обороты. Таким образом, работа оборудования не прекращается ни на секунду.

Схема построения N+1. При такой мощности вырабатываемой электроэнергии дизельный двигатель имеет большой расход топлива – более 350 литров в час, что потребовало дополнительного внешнего топливохранилища объемом более 100 тонн дизельного топлива.

В здании ЦОД две разнесенные электрощитовые. В каждой установлено по 2 ВРУ системы бесперебойного питания и 2 ВРУ системы гарантированного питания.

Система диспетчеризации контролирует состояние всех автоматических выключателей. Также установлены приборы технологического учета, что позволяет контролировать потребление электроэнергии по каждому направлению электропитания. Для обеспечения бесперебойной работы вспомогательных систем установлен шкаф со статическим электронным байпасом.

Система распределения также контролируется системой диспетчеризации, и каждая линия оснащена прибором технологического учета.

В малых залах размещены шкафы распределения, от них отходят линии к каждому серверному шкафу, в котором установлено по два блока распределения питания.

В больших залах для распределения электроснабжения был использован шинопровод. В отводных коробках каждый автомат также контролируется системой диспетчеризации, что позволяет постоянно получать полную картину о работе системы электроснабжения ЦОД.

Непосредственно в серверных шкафах для распределения электроэнергии установлены блоки распределения питания.

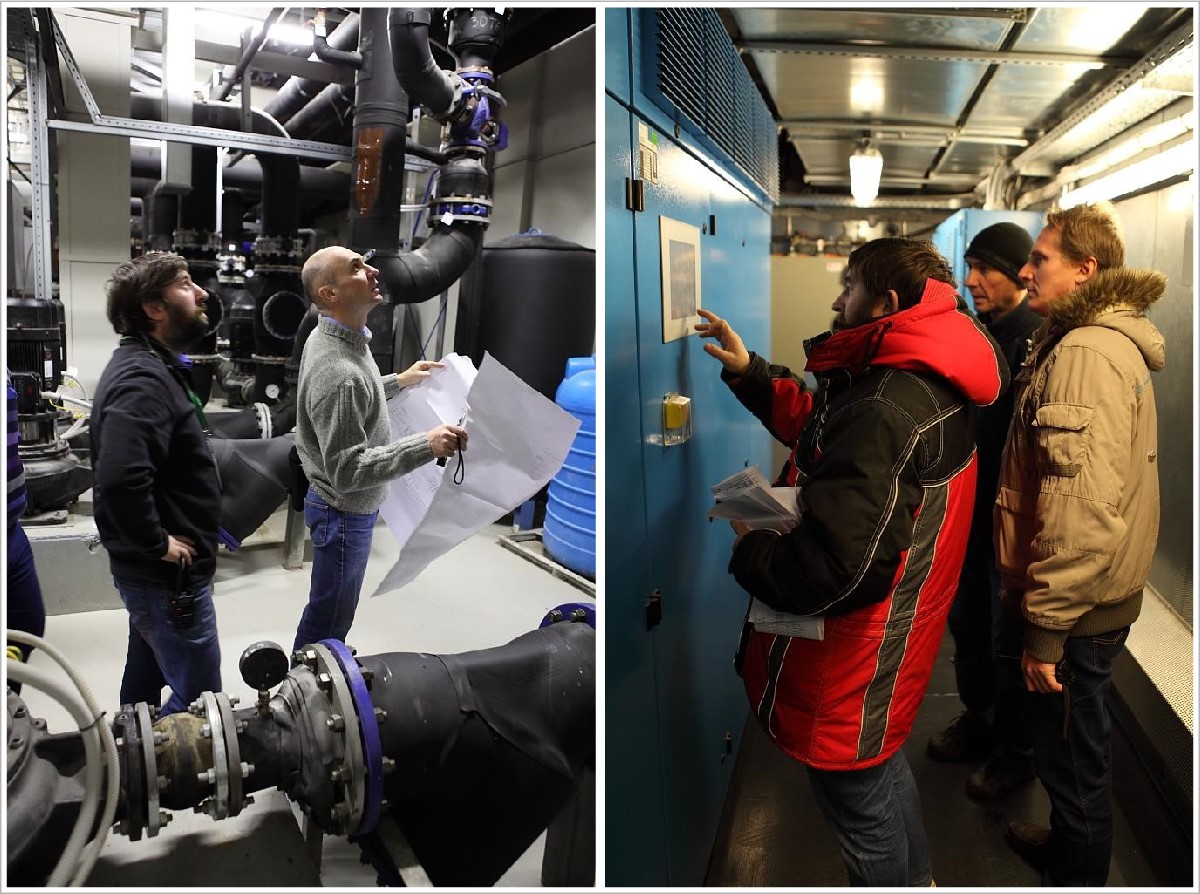

Охлаждение залов

На первом этаже в аппаратных и машинных залах ЦТО оборудование охлаждается с применением внутрирядных прецизионных кондиционеров Emerson (ранее приобретенных заказчиком) и с использованием водяных чиллеров и драйкулеров для подготовки захоложенной воды.

Для охлаждения залов второго этажа (с основной нагрузкой) мы применили кондиционеры с рекуператором воздух-воздух.

В четырех машинных залах второго этажа развернута инновационная система охлаждения от компании AST Modular, включающая в себя 44 модуля охлаждения наружным воздухом Natural Free Cooling.

Система представляет собой два разомкнутых контура. В одном из них циркулирует воздух из машинного зала, а в другой через систему технологической вентиляции подается прохладный воздух с улицы. Оба потока проходят через рекуперативный теплообменник, в котором происходит теплообмен между наружным и внутренним воздухом. Таким образом, оборудование может охлаждаться наружным воздухом до 90% времени в году, что позволяет на 20-30% снизить затраты на традиционное активное охлаждение с использованием водяных чиллеров и драйкулеров. Летом охлаждение воздуха производится захоложеной водой от чиллеров.

К началу проекта у нас уже был опыт создания подобных систем охлаждения: Natural Fresh Aircooling мы использовали в высокотехнологичном модульном ЦОДе «ВымпелКома» в Ярославле. Но каждый новый проект таит свои сложности.

Чтобы увязать работу кондиционеров MNFC с приточными установками воздуха (которые подготавливают уличный воздух, после чего подают его в технический коридор для MNFC), нам пришлось для кондиционеров MNFC на математическом уровне проработать зависимость объемов подаваемого воздуха и выбрасываемого вентустановками. Это связано с тем, что объем воздуха, который поступает в технический коридор, должен не превышать определенную границу (чтобы не задушить вентиляторы кондиционеров) и одновременно быть достаточным (чтобы воздух в коридоре не оказался разреженным).

Хладоцентр на первом этаже и оборудование на крыше

В помещении хладоцентра (ХЦ) разместили чиллерные машины, насосные группы, теплообменики и т.д.

Водяные чиллеры и драйкулеры используются для подачи захоложенной воды в установки Natural Free Cooling на втором этаже в жаркое время года и в кондиционеры на первом этаже постоянно. Зимой охлаждение воды осуществляется через теплообменник в ХЦ и градирни на крыше, что также позволяет не включать чиллеры и экономить электроэнергию.

По проекту, большой объем оборудования нам нужно было установить на крыше ЦТО, поэтому пришлось практически построить третий этаж в виде стотонной рамы и установить на нее около 60 тонн оборудования: градирни, длина которых достигала 14 м, и мощные вентустановки выше человеческого роста.

С градирнями мы, конечно, попотели: попробуй подними такую громадину на крышу! Из-за больших габаритов оборудования пришлось варить специальную балку для разгрузки, а также использовать кран грузоподъемностью 160 т с большой стрелой, и даже такой кран местами проседал.

Пожарная безопасность

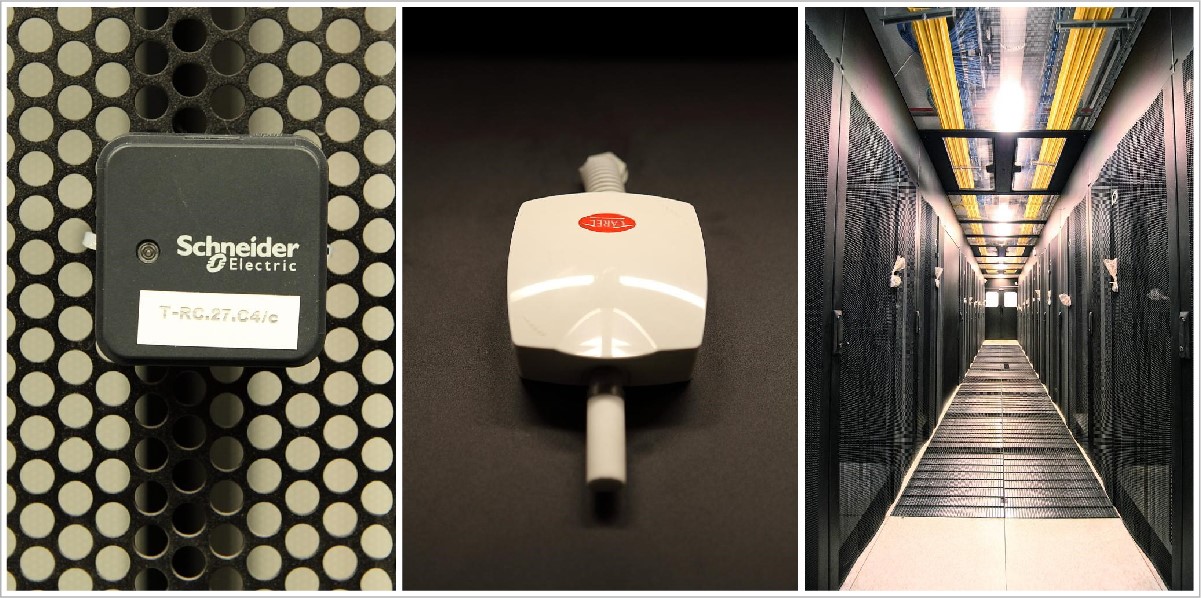

Для пожарной безопасности на площадке развернуты системы пожарной сигнализации, раннего обнаружения пожара (аспирационная система – датчики, анализирующие состав воздуха), автоматического газового пожаротушения и система газоудаления, которая позволяет удалять остатки газа после отработки системы пожаротушения.

Система оповещения о пожаре работает следующим образом: пожарные датчики машинных залов, аппаратных, а также вспомогательных помещений выдают соответствующие сигналы на центральную станцию автоматической пожарной сигнализации, которая, в свою очередь, запускает систему автоматического газового пожаротушения, пожарную автоматику и систему оповещения, в зависимости от зоны возникновения пожара.

В качестве основного было использовано оборудование ESMI (Schneider Electric). Оно закрыло все задачи по обеспечению пожарной безопасности и отображается на рабочей станции оператора в диспетчерской.

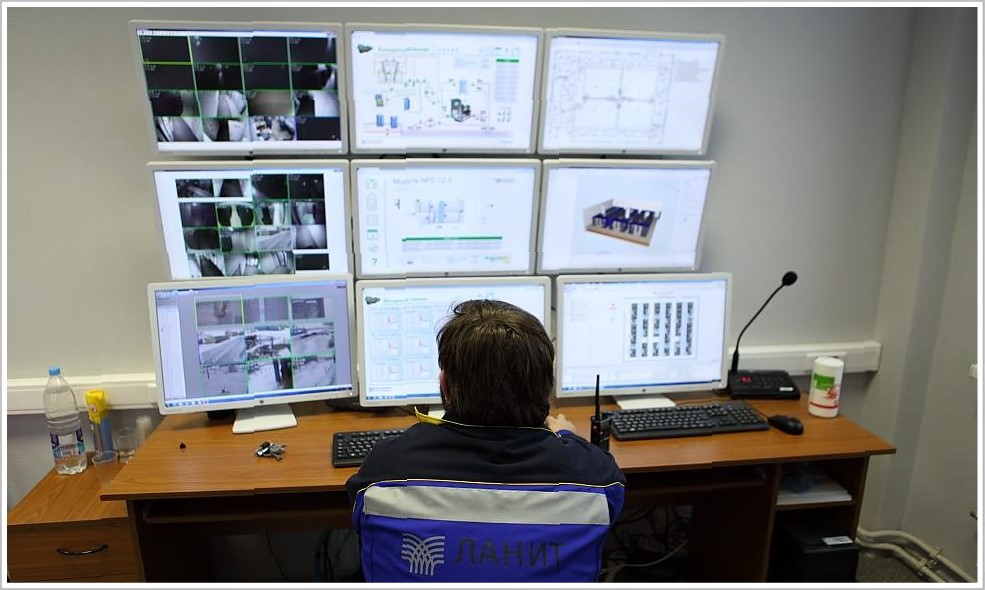

Система автоматизации и диспетчеризации ЦОД

В большинстве ЦОД ставят только локальную автоматизацию с минимальным набором функций мониторинга, а у нас все подсистемы интегрированы в единое техническое решение с общей системой контроля. Система контроля отслеживает состояние более 10 систем и выводит более 20 тыс. параметров. Хотите узнать температуру и влажность в машинных залах или вас интересует потребление электроэнергии по каждой ИТ-стойке? Без проблем.

В рамках системы мониторинга и диспетчеризации мы использовали как SCADA-систему, так и систему мониторинга и менеджмента ЦОД. SCADA-система (Supervisory Control And Data Acquisition — диспетчерское управление и сбор данных) позволяет просматривать данные и управлять автоматикой установленного оборудования: чиллера, кондиционера, дизельно-роторных ИБП, вентиляции, насосов и т.д.

Система учета ресурсов дата-центра позволяет вести полный учет всего оборудования, установленного в стойках. Она в реальном времени отображает аварийные сообщения, данные о состоянии оборудования с визуализацией на детальном плане размещения. Благодаря детализации мы можем увидеть любое устройство, расположенное в ЦОД.

Система позволяет моделировать аварийные ситуации и выдает рекомендации по решению проблем, а также позволяет планировать и оптимизировать эксплуатацию технических ресурсов ЦОД.

Здесь также ведется контроль и управление вентиляционными системами (в том числе контроль температуры подаваемого ими воздуха, так они участвуют в технологическом процессе охлаждения ИТ-оборудования). Учитываются все параметры по кондиционерам, вентиляционным установкам и системам холодоснабжения.

Система отслеживает состояние оборудования и управляет им (и различными клапанами). Кроме того, она дополнительно защищает оборудование от критических режимов.

Система контролирует состояние всех основных аппаратов защиты в электрошкафах, а также электропотребление на данных линиях.

Система позволяет вести учет установленного оборудования в ИТ-стойках, а также хранить информацию о его принадлежности. Сюда стекаются данные с противопожарных систем и системы безопасности здания.

Управление зданием осуществляется при помощи решений, построенных на оборудовании компании Schneider Electric. Автоматизированная система диспетчеризации, мониторинга и управления инженерными системами предоставляет всю необходимую информацию диспетчеру на его рабочем месте.

Системы связаны между собой посредством технологического сегмента сети передачи данных. Программное обеспечение установлено на виртуальных машинах, обеспечено резервное копирование данных.

Для обеспечения безопасности, видеонаблюдения и контроля доступа в ЦОД также было установлено централизованное решение Schneider Electric. Оно выдает необходимую информацию в систему диспетчеризации ЦОД.

Всё оборудование, о котором я рассказал, собрано в отказоустойчивой конфигурации и размещено в модульных помещениях Smart Shelter, обеспечивающих надежную защиту ЦТО от пожара, влаги, вибрации и других внешних воздействий. Данное решение позволило сократить срок реализации проекта. На сборку одного помещения в среднем ушло две недели.

Пройти огонь, воду и… экзамен Uptime Institute

Чтобы сдать экзамен на соответствие ЦОД стандартам Tier III Design и Tier III Facility, нам пришлось выполнить всю документацию согласно требованиям Uptime Institute, пройти ее сертификацию и по этой документации смонтировать и запустить все системы. В финале мы выдержали тестирование систем дата-центра на соответствие Tier III Facility. А это порядка 50 тестов!

Подготовка к испытаниям оказалась непростой: если сертификация документации понятна, то найти информацию, как проходит сертификация самого объекта, было крайне сложно (на тот момент ЦОД «Жигулевской долины» оказался седьмым в России дата-центром, проходящим сертификацию).

Много сил ушло на внутренний аудит (испытания под нагрузкой уже ранее проводились для заказчика). Две недели мы друг за другом все проверяли в соответствии с проектной документации и тестами, полученными от Uptime Institute, и все равно, конечно же, нервничали во время сертификации.

Когда специалисты Uptime Institute приехали в ЦОД с инспекцией и стали осматривать залы, я для себя на будущее сделал важный вывод – в команде должен быть один лидер, который возьмет на себя общение с «экзаменаторами». О том, кто станет таким человеком, нужно подумать еще на этапе формирования команды. Мы постарались именно так и сделать, и все же в процессе испытаний некоторые наши сотрудники пытались проявить инициативу. Представители Uptime Institute, замечая сторонние обсуждения, сразу же задавали дополнительные вопросы.

Первый день был ознакомительным: инспектор осматривал ЦОД на соответствие проектной документации.

На следующий день для ключевого тестирования Uptime Institute нужно было дать полную нагрузку ЦОД – как тепловую, так и в части энергопотребления. Нагрузку имитировали специально установленные тепловые пушки мощностью 30-100 кВт.

Для некоторых тестов оборудование переводилось в критический режим, и были опасения, что системы не выдержат. Чтобы обезопасить оборудование от возможных последствий (как говорится, береженого Бог бережет), мы пригласили инженеров со стороны производителей оборудования.

За всем происходящим из диспетчерской в режиме реального времени наблюдал один из инспекторов Uptime Institute – Фред Дикерман. Автоматизированная система диспетчерского управления и множество датчиков позволяли отслеживать текущее состояние оборудования и изменение температур в машинных залах.

Результаты сертификации показали, что мы изначально заложили верные технические решения, все корректно смонтировали и запустили. Со слов экспертов, данный ЦОД оказался единственным в России, который прошел проверку Uptime Institute без замечаний.

Источник: habr.com