Строительство собственного дата-центра для размещения серверов занимает время и обходится дорого, поэтому многие компании предпочитают аренду ЦОД. Это удобно для быстрого старта проекта, требует минимум затрат. Но от надежности центра обработки данных зависит деятельность всей компании, поэтому крупному, среднему и малому бизнесу будет полезно рассмотреть нынешнюю ситуацию с ЦОД в России. Это поможет определиться с выбором.

С началом пандемии наблюдался спад спроса на услуги ЦОД, поскольку компании сосредоточились на закрытии краткосрочных потребностей или вовсе приостановили свою деятельность. Но затем пошел тренд на удаленную работу, что увеличило потребность в росте хранилищ, вычислительных мощностях для обработки данных. Чтобы сэкономить на оборудовании, многие компании стали пользоваться облачными сервисами, доступ к которым сохраняется из любой точки мира. Согласно отчету Gartner, 90% данных обрабатываются в дата-центрах.

В 2021 году объем рынка коммутаторов вырос на 5% и эти темпы продолжаются. Сейчас это привлекательная отрасль для инвестиций. Набирают тренды «зеленые» дата-центры с экологичными технологиями, системами водяного охлаждения или вообще размещаемыми под водой.

Кто работает в ЦОД? Ежедневный обход с дежурным инженером.

Сразу оговоримся, что услуги ЦОД лучше выбирать от тех компаний, оборудование которых физически расположено в России. При любых изменениях во внутренней и внешней политике у вас останется доступ к информации, а фирма продолжит свою деятельность. Вкладывать средства и загружать данные на сервера, находящиеся за пределами РФ очень рискованно. Рассмотрим несколько примеров популярных ЦОД Москвы с высоким уровнем защиты как техники, так и данных.

Компания Contell предоставляет услуги ЦОД в Москве. Клиентам предлагается 352 стойки с оборудованием, установленные на общей площади в 792 м². Повышенной надежности содействуют:

● наличие круглосуточного поста охраны;

● полный обход всех машинных залов 6 раз в сутки;

● регулярные снятия показателей стабильности;

● автоматическая система тушения пожара газом, не повреждающая сервера.

Уровень надежности ЦОД в Москве ― Tier III. Бесперебойность работы обеспечивается наличием резервных мощностей и двумя трубопроводами для системы охлаждения. Даже на время обслуживания или ремонта нет необходимости прерывать работу. Устойчивость к отказам достигает показателя 99,982%. Быстрый доступ к данным предоставляет 40-гигабитная сеть между оборудованием и хранилищем.

Источник: vc.ru

Данные стремятся к центру

«Ростелеком-ЦОД» замораживает региональные проекты в пользу Центрального округа из-за неблагоприятной экономической ситуации и дефицита необходимого для строительства импортного оборудования. Некоторым конкурентам компании пока удается найти технику и продолжать проекты. Участники рынка, которых не затронули санкции, могут иметь преимущество перед «Ростелекомом», признают эксперты. Но в целом они ожидают снижения коммерческого спроса на дата-центры из-за остановки проектов цифровизации.

Pro Hi-Tech в ЦОД Tier III. Дизельные ИБП, продвинутое охлаждение Schneider и многое другое

Фото: Анатолий Жданов, Коммерсантъ

Фото: Анатолий Жданов, Коммерсантъ

Один из крупнейших игроков на российском рынке вычислительных мощностей «Ростелеком-ЦОД» прекращает строительство дата-центров в регионах, рассказал “Ъ” источник и добавил, что в июне свой пост покинул гендиректор DataLine (принадлежит «Ростелекому») Юрий Самойлов.

В компании подтвердили, что экспансия в регионы приостановлена, «чтобы дождаться стабилизации ситуации на рынке».

Глава дирекции по интеграционным проектам «Ростелеком-ЦОД» Сергей Крюков уточнил, что компания сосредоточена на завершении строек в Москве и Петербурге.

Среди других городов, где «Ростелеком» планировал наращивать мощности, были Екатеринбург и Удомля (см. “Ъ” от 11 ноября 2021 года). Но сейчас компании важнее «сдать те проекты, которые уже близки к завершающей стадии», полагает ведущий консультант iKS-Consulting Станислав Мирин. Он отметил, что пока нельзя оценить перспективы восстановления экспансии: «Не до конца ясно, что будет происходить как с техническим обеспечением, так и со спросом на услуги ЦОДов: он определяется количеством устанавливаемых их клиентами серверов, а их официальный ввоз в страну ограничен».

В конце апреля в Московском регионе, на который приходится 72% российского рынка дата-центров, осталось всего 800 свободных стойко-мест.

Цены на их аренду выросли в среднем на 25% (см. “Ъ” от 28 апреля). При этом в отрасли обостряется дефицит комплектующих для строительства дата-центров и поддержки действующих, которые ранее закупались у зарубежных производителей: Schneider Electric, Stulc, Vertiv. В 2021 году рынок услуг ЦОД в России достиг порядка 48,5 тыс. стоек. В числе крупнейших участников были «Ростелеком», DataPro, IXcellerate, Selectel, МТС, «Крок».

Руководитель направления ЦОД «Крок» Сергей Махлин рассказал, что заказчики компании столкнулись с беспрецедентной ситуацией: с одной стороны, есть потребности в развитии цифровой инфраструктуры, с другой — сложности с поставками оборудования. В результате «часть клиентов взяли паузы, чтобы понаблюдать за развитием ситуации».

Но далеко не все участники рынка коммерческих ЦОД останавливают проекты.

Директор по инфраструктуре Selectel Алексей Еременко говорит, что компания не корректировала планы ввода новых стоек и выполняет их. Развитие инфраструктуры МТС также идет по плану, говорят в компании: «Мы находим замену оборудованию, которое стало или может стать недоступным».

Оборудование, необходимое для строительства дата-центров, сейчас невозможно покупать у традиционных западных поставщиков, объясняет основатель дата-центра и облачного провайдера Oxygen Павел Кулаков. По его словам, часть комплектующих, заказанных еще в прошлом году для уже строящихся проектов, просто не доехала — автоматические выключатели, блоки вентиляторов, дизельные двигатели и т. д. «С серверным оборудованием еще больше сложностей: возможна поставка очень небольшими, ограниченными партиями. Наиболее доступный вариант доставки — по железным дорогам, но, например, путь из Владивостока до Москвы имеет ограниченную пропускную способность, и сейчас график доставок расписан до осени»,— объясняет господин Кулаков.

Строительство ЦОДов в Москве и области обещает стать дольше и дороже

Компании с достаточными денежными или техническими ресурсами, которых при этом санкции не затронули напрямую, имеют преимущество над «Ростелекомом», считает президент Ассоциации участников отрасли ЦОД Игорь Дорофеев. Окончательного переформатирования рынка, по его оценкам, можно ожидать в течение двух лет, при этом на процесс будет влиять государство: «Коммерческий спрос в условиях падения будет замещаться государственным — очевидно, по более низким тарифам. Исходя из этого, и затраты на решения будут ниже».

Источник: www.kommersant.ru

Что нам стоит ЦОД построить

Артем Коваленко

19 сентября 2022, 00:00

Санкции ускорили тенденцию строительства дата-центров в регионах

Ростелеком прорабатывает проект создания центра обработки данных (ЦОД) на Дальнем Востоке, стало известно на Восточном экономическом форуме, который проходил 5 — 8 сентября на острове Русском. «Мы выбираем между Владивостоком и Хабаровском, нужен подходящий земельный участок и электричество, хотелось бы уже в рабочем порядке обсудить этот вопрос», — цитирует президента компании Михаила Осеевского пресс-служба правительства Приморья. Несколькими днями ранее, 2 сентября, вице-премьер Дмитрий Чернышенко посетил строительную площадку ЦОД Сбера в Балакове Саратовской области.

Этот дата-центр станет крупнейшим в России. «Минцифры поручено совместно со Сбером проработать вопрос использования вычислительной инфраструктуры регионального центра для геораспределенного резервирования сервисов цифровой платформы “Гостех” и гособлака. Дата-центр сможет обеспечить мощностями не только регионы ПФО, но и соседние федеральные округа», — заявил зампред правительства.

ЦОД в Саратовской области — первый этап развития программы строительства сети региональных ЦОД Сбера. Весной 2023 года планируются монтаж и тестовый запуск первых двух модулей. Формирование сети дата-центров за пределами Москвы и Санкт-Петербурга — один из главных трендов нового времени. Как будет развиваться региональный рынок ЦОД в отсутствии иностранных поставщиков оборудования?

Нашли альтернативу

Игроки рынка констатируют, что спрос на услуги дата-центров резко вырос в начале 2022 года. По оценкам экспертов четвертого международного форума Ассоциации участников отрасли ЦОД, в 2022 году в отечественных дата-центрах оставались свободными 1,3% стоек, хотя год назад их доля составляла 7%. «Во многом такая тенденция связана с тем, что ряд санкций подтолкнул компании перенести свою инфраструктуру от зарубежных операторов или осуществить ее резервирование в российских дата-центрах», — объясняет генеральный директор сети дата-центров 3data Илья Хала.

По данным CNews Analytics, в прошлом году крупнейшие операторы российских дата-центров запустили в коммерческую эксплуатацию 4784 стойко-места: их количество выросло с 41 тысячи на конец 2020 года до 46 тысяч на конец 2021-го. Лидирует по запуску мощностей компания DataPro, которая в течение года ввела в строй 1660 стоек. На втором месте IXcellerate (629 стоек). Ростелеком увеличил мощности на 499 стоек, в основном за счет расширения площадки Nord 6 в Москве (на 207 стоек) и запуска нового дата-центра в Новосибирске (+304). Также среди лидеров Гознак, запустивший ЦОД в Санкт-Петербурге (470 стоек).

При этом ЦОД-провайдеры не реализовали свои планы по расширению даже на 50%. Годом ранее компании оглашали намерения по сдаче в эксплуатацию 12,6 тыс. стойко-мест до конца 2021 года, однако значительная часть проектов была перенесена на более поздний срок. В IXcellerate, например, снижение темпов объясняют «санкциями, повлекшими за собой проблемы с доставкой оборудования», но по-прежнему уверены в положительной динамике индустрии ЦОД:

— Сроки запуска новых мощностей сейчас скорректированы, но мы почти нагнали необходимый темп ввода, исходя из текущих потребностей заказчиков, — рассказывает генеральный директор IXcellerate Андрей Аксенов. — Стратегия IXcellerate не менялась последние десять лет, не меняется и сейчас. Мы продолжим оказывать высоконадежные услуги colocation и строить коммерческие дата-центры, гарантируя клиентам возможности масштабирования ИТ-инфраструктуры на многие годы вперед.

— Темпы роста сегмента ЦОД в последние годы были стремительны, зона роста в 2022 году казалась нескончаемой, и на февраль 2022 года многие проекты находились в стадии строительства или проектирования. Из-за введения санкций существенный объем инженерных систем ЦОД, поставляемый зарубежными вендорами, завис на этапе поставок, — говорит руководитель направления продаж услуг ЦОД и облака «Гознак» Оксана Смирнова. — Однако участники рынка дата-центров уже нашли альтернативные пути решения этих проблем: российские поставщики, параллельный импорт, а также работа с поставщиками, не приостановившими поставки.

Илья Хала считает, что необходимо искать аналоги, которые производят российские компании: «У нас немало достойных отечественных технологий. Например, в стране существует достаточное количество производителей холодильных систем, которые раньше работали на “оборону”, а теперь готовы переходить и на гражданскую технику. Более того, рынок не стоит на месте, и в какой-то степени развитию способствует государство, которое начало предоставлять производителям различные льготы, выделять средства и предлагать прочие меры».

Региональная сеть будет развиваться

Крупные игроки продолжат региональную экспансию. Пока, по данным CNews, большая часть предложения сосредоточена в Москве: на нее приходится 35,3 тыс. стоек, или около трех четвертей (76%) доступной емкости. Далее следует Санкт-Петербург — 6551 стойка (14%). В остальных регионах — только 10% ресурсов коммерческих ЦОД (4420 стоек).

— Наибольшая доля всего российского рынка колокейшн, порядка 70%, приходится на Москву и Подмосковье, — подтверждает Оксана Смирнова. — Но бизнес в регионах растет, и ему необходима надежная локальная инфраструктура для стабильного развития. Дополнительным стимулом в развитии региональных ЦОД может послужить и перевод ИТ-систем местных органов власти в региональные коммерческие дата-центры. Крупнейшие операторы ЦОД считают российские миллионники перспективным направлением для развития бизнеса даже в сложивших условиях и будут способствовать его развитию.

— Нет сомнений, что региональная сеть дата-центров в России будет развиваться. В регионах находится множество важных промышленных производств, развиваются программы цифровой экономики и безопасного города, — согласен директор центра компетенций по инженерной инфраструктуре Т1 Интеграции Алексей Карпов. — У крупных предприятий наметилась тенденция размещения корпоративных ЦОД в регионах присутствия рядом с мощными энергетическими узлами. Крупными региональными хабами для размещения ресурсов ЦОД являются Казань, Екатеринбург, Новосибирск и Владивосток.

Самой разветвленной сетью региональных дата-центров располагает Ростелеком: объекты расположены в более чем десятке городов, самые крупные — в Удомле (800 стоек), Новосибирске (304 стойки), Екатеринбурге (216 стоек).

— В первую очередь мы ориентируемся на спрос со стороны заказчиков.

И если в регионах нашего присутствия, в частности в Екатеринбурге, бизнес будет нуждаться в вычислительных мощностях, то мы продолжим развивать наши проекты. На данный момент мы планируем ввод в эксплуатацию второй очереди дата-центра в Екатеринбурге на 216 стоек в первом квартале 2023 года, — говорит директор дирекции по интеграционным проектам «Ростелеком-ЦОД» Сергей Крюков.

— 3data продолжает расширять сеть дата-центров в регионах по модели франшизы. Так, в апреле мы объявили о подписании договора на строительство дата-центра в Иркутске, а также ведем переговоры с более чем десятью городами по возможности сотрудничества, — рассказывает и Илья Хала.

— Потребность в надежных услугах по хранению и обработке данных, возможность получать в самых разных точках страны единый гарантированный и стандартизованный набор сервисов только возрастает. Появятся совершенно новые форматы и подходы к организации ЦОД, которые должны будут стать своего рода центрами бизнес-активности, предлагающими бизнесу широкий набор соответствующих услуг, включая коммуникационные пространства, коворкинги, помещения для проведения конференций и для повседневной офисной работы, — прогнозирует генеральный директор «Либерум Навитас» Айрат Мустафин.

Аналитики CNews заключают, что, несмотря на текущий дефицит оборудования, вызванный санкциями, темпы роста останутся на уровне 10 — 15% в год: в течение 2022 года компании обещают ввести в строй 9622 стойко-места, а в 2023 году, когда игроки отрасли рассчитывают наладить новые каналы поставок оборудования, — 13 714.

Бизнесу нужны готовые ИТ-решения

Отрасль ЦОД будет развиваться в направлении сложных ИТ-продуктов и станет центром компетенций, считает генеральный директор сети дата-центров Oxygen Павел Кулаков

— Что будет с рынком ЦОД в условиях санкций и дефицита оборудования?

— ЦОД всегда являлись производным состояния ИТ-отрасли. Это открытая система, которая чутко реагирует на рынок. Именно бизнес формирует ИТ-климат, ставя перед технологическими компаниями конкретные задачи. Крупнейшие компании создавали спрос на технологические решения, формировали цифровые экосистемы, шли в диджитализацию. Сейчас эти процессы замерли.

Причина: ландшафт потребительского рынка меняется, бизнес пытается выстроить новые модели. Фактически требуется переосмыслить подходы к ИТ.

Что будут делать в текущих условиях ЦОД? Мы отчетливо видим такую тенденцию — заказчики все чаще обращаются к облачным провайдерам и ЦОД не столько за арендой места под собственные сервера, сколько за готовыми ИТ-решениями. На наш взгляд, отрасль будет развиваться в направлении сложных ИТ-продуктов, станет центром компетенций, интенсивно увеличивая количество и расширяя спектр не столько новых стойко-мест, сколько цифровых ИТ-продуктов. Понимая этот тренд, мы запускаем целую серию продуктов «как сервис»: базы данных Oracle, Postgres, SAP, 1С из облака, Облако ФЗ, аварийное восстановление и бэкап, а также импортозамещенный VDI. Продукты по подписке обеспечат безопасность инфраструктуры.

— Продолжится ли региональная экспансия?

— Концепция экспансии определяется кругом потенциальных потребителей услуг дата-центра в регионе. Соответственно, строительство больших проектов федерального масштаба на данном этапе нецелесообразно. Крупные региональные

ЦОДы не будут востребованы крупными заказчиками (такими как банки, медиа, соцсети, e-com) в той же степени, что и в Москве.

Факторы, которые определяют характер региональной экспансии, следующие: сложность в закупке оборудования; недостаток ИТ- и ИБ-экспертизы на местах; неразвитость инфраструктуры; недостаток инвестиций; слабая магистральная связность; федеральная стратегия цифровизации регионов. Эти предпосылки определяют стратегию экспансии — большая сеть компактных распределенных ЦОД; наличие готовой облачной инфраструктуры; отраслевые продукты и продукты ИБ в режиме Plug-and-play; аренда серверного оборудования; программное обеспечение по подписке; гособлако.

Мы считаем, что России требуется широкая распределенная сеть компактных региональных дата-центров. Их задача — покрыть всю территорию страны и стать основой цифровизации в регионах. Благодаря широкой сети дата-центров конечным потребителям даже в самых отдаленных уголках России будут с минимальными задержками доступны отраслевые продукты для бизнеса и инновационные технологии — искусственный интеллект, машинное обучение, компьютерное зрение, беспилотный транспорт, а также цифровые сервисы для населения, такие как электронные медицинские карты и электронный дневник.

IXcellerate открыл третий дата-центр в России

«Все стратегические цели сохраняются, мы запускаем новые объекты в четко обозначенные сроки и собираемся придерживаться намеченных планов», — говорит СЕО IXcellerate Андрей Аксенов

12 сентября компания IXcellerate объявила о завершении строительства и запуске первой очереди третьего дата-центра — MOS5. Новый ЦОД — первый действующий объект в Южном кампусе IXcellerate, расположенном в районе Бирюлево Москвы. Площадь кампуса — 14 гектаров.

Дата-центр готов к эксплуатации: функционирует 1516 стойко-мест, обеспеченных электроэнергией в объеме 17 МВт по схеме двойного резервирования. Все стойки выкуплены еще на этапе строительства. Команда IXcellerate уже приступила к строительству второй очереди MOS5 на 836 стойко-мест, более 75% из них зарезервированы действующими клиентами. Полный ввод всех пяти очередей дата-центра намечен на 2024 год. Его совокупная емкость составит 4722 стойко-места, а энергомощность — 64 МВт, рассказывает СЕО IXcellerate Андрей Аксенов.

— MOS5 спроектирован с учетом всех требований Tier III и рассчитан на размещение комплексных решений любой степени сложности, в том числе высоконагруженных серверов и инфраструктуры для сверхплотных вычислений с нагрузкой до 20 кВт на стойку. Клиентами дата-центра станут компании разного масштаба, среди действующих резервов есть заявки на гиперинсталляции (от 250 стоек с ИТ-нагрузкой в 2 МВт и более). Доступность услуг гарантируется на уровне не менее 99,982%.

В ходе строительства дата-центра использованы лучшие инженерные практики. Например, система охлаждения Low Speed Ventilation спроектирована по технологии «холодная стена» и не требует создания фальшпола. Построена уникальна система физической безопасности дата-центра, которую обеспечивают шесть рубежей. В частности, в ней используется технология «ЦОД в ЦОДе» (модули размещаются под «саркофагом» наружного здания); установлена бесконтактная система распознавания Face ID для управления уровнем доступа; работает система тамбур-шлюзов и турникетов.

MOS5 включен в единую телекоммуникационную транспортную систему IXcellerate: он обеспечен тремя подключениями к кабельной канализации и соединен оптическими магистралями с Северным кампусом по двум независимым трассам, благодаря чему его клиенты могут подключаться к любому из провайдеров телеком-услуг — партнеров IXcellerate, а также к пиринговой платформе Eurasia Peering.

Общее количество стойко-мест во всей экосистеме IXcellerate (Северный и Южный кампусы) — около 5 тыс. единиц. В период с 2022 по 2031 годы мы планируем расширить обе площадки, построить еще пять новых объектов и сохранить позиции в топ-3 игроков на рынке коммерческих дата-центров России. В перспективе десяти лет экосистема IXcellerate будет насчитывать восемь дата-центров, а Южный кампус при полном вводе станет крупнейшей площадкой ЦОД среди нейтральных операторов коммерческих дата-центров в Европе.

Цифровизация в России продолжается, и спрос на услуги обработки данных постоянно растет, особенно в последнее время. Мы должны постоянно развиваться, наращивать мощности и быть на шаг впереди рынка, чтобы обеспечить российским компаниям непрерывность бизнеса и высококачественный сервис в любой ситуации. Все стратегические цели IXcellerate сохраняются, мы запускаем новые объекты в четко обозначенные сроки и собираемся придерживаться намеченных планов.

Связь в руднике: «Ростелеком» протестировал беспроводную сеть на Учалинском горно-обогатительном комбинате

«Ростелеком» протестировал беспроводную широкополосную сеть с использованием технологии private LTE (pLTE) на Учалинском горно-обогатительном комбинате (г. Учалы, Республика Башкортостан).

Благодаря организованной инфраструктуре сотрудники предприятия, работающие в руднике, смогут поддерживать связь друг с другом, а также с коллегами на поверхности.

Private LTE — выделенная беспроводная высокоскоростная сеть — позволяет организациям безопасно использовать передачу данных, видеонаблюдение, дистанционное управление и другие телекоммуникационные сервисы. Контролируемая цифровая среда изолирована от публичных сетей мобильной связи, устойчива к помехам и хорошо защищена.

Иван Пичугин, вице-президент «Ростелекома» на Урале:

«Компания успешно завершила пилотный проект по тестированию pLTE на Учалинском ГОКе. Условия, в которых наши специалисты устанавливали оборудование, были сложными, работали под землей на глубине 860 метров в нетипичной для себя среде. Для обеспечения защиты инфраструктуры связисты крепили устройства там, где их не смогла бы задеть проезжающая техника. В результате удалось организовать качественный беспроводной канал связи, который проходит через 140 метров горой породы».

Закария Гибадуллин, директор АО «Учалинский ГОК»:

«Пилотный проект тестирования беспроводной высокоскоростной сети передачи данных в подземных выработках Учалинского ГОКа реализован в рамках программы цифровой трансформации. По результатам тестирования мы видим дальнейшие перспективы применения данной технологии».

Источник: expert.ru

Особенности строительства национальных дата-центров, Михалыч

Проводим измерения для прохождения сертификации по Tier 3 в дата-центре в Стамбуле. И нет, на фото не я.

Я руковожу проектами создания ЦОДов в России и за рубежом. И хочу рассказать о том, как в последние годы российские ЦОДы приобретают свой особый стиль проектирования.

И я не про истории вроде того, что если в проекте есть контейнерный дизель-генератор, то надо обязательно сразу спроектировать площадку для курения близко к выходу из здания. Потому что, если так не сделать, народ будет курить за ДГУ и бросать бычки на землю или прямо в дырку вентиляции. А когда его нужно будет завести, он заберёт потоком воздуха их все в радиусе пары метров и сразу забьёт фильтр.

Скорее речь идёт о более глобальных вещах, касающихся общих идеи и стиля проектирования. Основывается этот стиль на том, что российский заказчик обычно знает, что ему нужен ЦОД, но не знает, какое ИТ-оборудование он поставит в него через год или два, не говоря уже про перспективу десяти лет. Поэтому дата-центр проектируется максимально универсальным. Если описать это как «следующие десять лет размещать любое оборудование, которое выходит на рынок», то не особо промахнётесь. В итоге получается, что проект ЦОДа нацелен на то, чтобы объект легко модернизировался в будущем без переделки здания, капитальных реноваций и так далее.

Пример: никто не знает «на берегу» какую необходимо делать ширину «холодного» коридора. Да, есть минимальные нормативы, но мы в последние годы стараемся сделать его шириной не менее 2,4 метра, потому что есть негабаритное оборудование в своём конструктиве, которое от 1 500 мм в глубину и необходимо учитывать его радиус поворота, закладывая ширину коридора.

Потом проектируется универсальная система кондиционирования для машзалов. Если несколько лет назад было вполне достаточно классической схемы с горячим и холодным коридором, то сейчас нагрузка на стойку растёт и требуется применять различные способы «доохлаждения» оборудования в высоконагруженных стойках.

Раньше средним значением было 4–5 кВт на стойку, сейчас заказчики требуют не менее 7–10 кВт, причём в середине машзала могут стоять отдельные стойки с максимальной нагрузкой до 20 кВт. Нужны новые подходы к размещению как ИТ-оборудования, так и кондиционирующего оборудования в машинном зале. Сейчас появились кондиционеры на шкафы для экономии площади, но они требуют особенного помещения (с потолками выше). Появились активные плитки фальшпола — раньше их тоже не было.

Часто бывает, что идёт модернизация, кондиционеры уже не тянут — они когда-то были рассчитаны на стойку 3 кВт, а сейчас нужно с тех же стоек снять 7 кВт. Заказчик говорит: меняем всё. Где-то это получается, где-то нет. В отдельных случаях меняем всё, но иногда меняем только внутренние блоки, а чиллеры оставляем старые, если они позволяют снимать новые нагрузки и только проверяем их ресурс. Часто проще дооснастить новыми кондиционерами и распределить потоки плитками.

Отдельно хочется отметить проекты, в которых подобная модернизация выполняется «на горячую», то есть, когда бизнес-процессы нельзя прерывать ни на секунду, а значит нельзя останавливать и ИТ-оборудование. Настоящий вызов для всей проектной команды: сжатые сроки, высочайшая ответственность, работа без выходных (а иногда и 24/7). А если ещё и помещение небольшое, где два такелажника плечами друг в друга упираются…

Модернизация систем бесперебойного электроснабжения тоже заслуживает отдельного упоминания. Попадаются проекты, в которых инженеры будто намеренно делали всё, чтобы их детище сохранилось в первоначальном виде до самой старости. Смотрим с заказчиком однолинейку и вместе натыкаемся на различные «препятствия». Такие бывают «узкие места», схема настолько сложна, что трудно поверить, что она вообще работает.

Принцип KISS (Keep it simple, stupid!) явно не использовался.

Или вот шинопроводы внутри машзала: высокая скорость монтажа, освобождается место под фальшполом, гибкость и удобство при эксплуатации — ввод электропитания «сверху» позволяет легче добавлять или перемещать стойки.

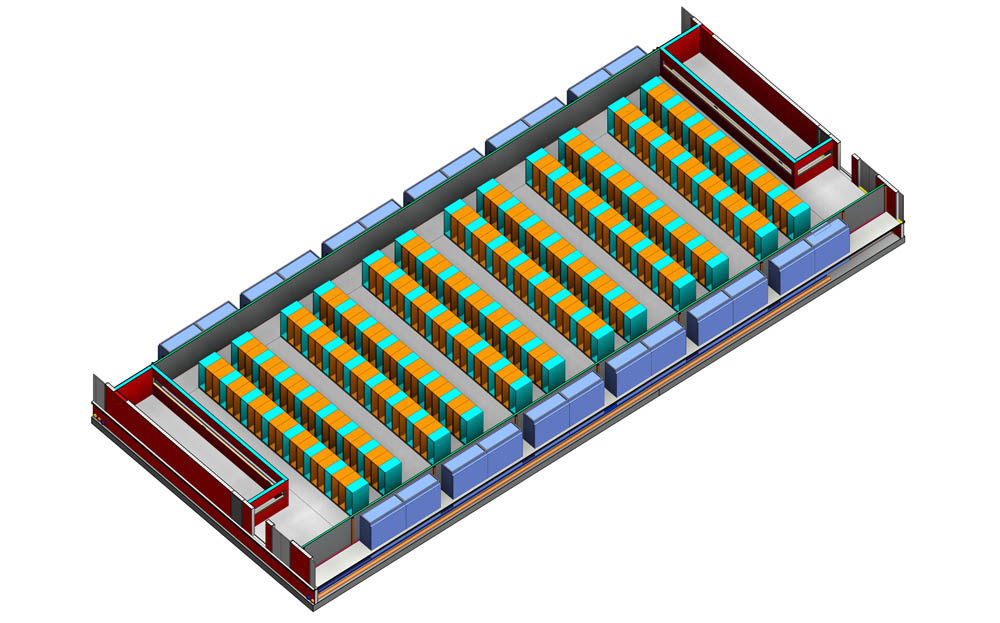

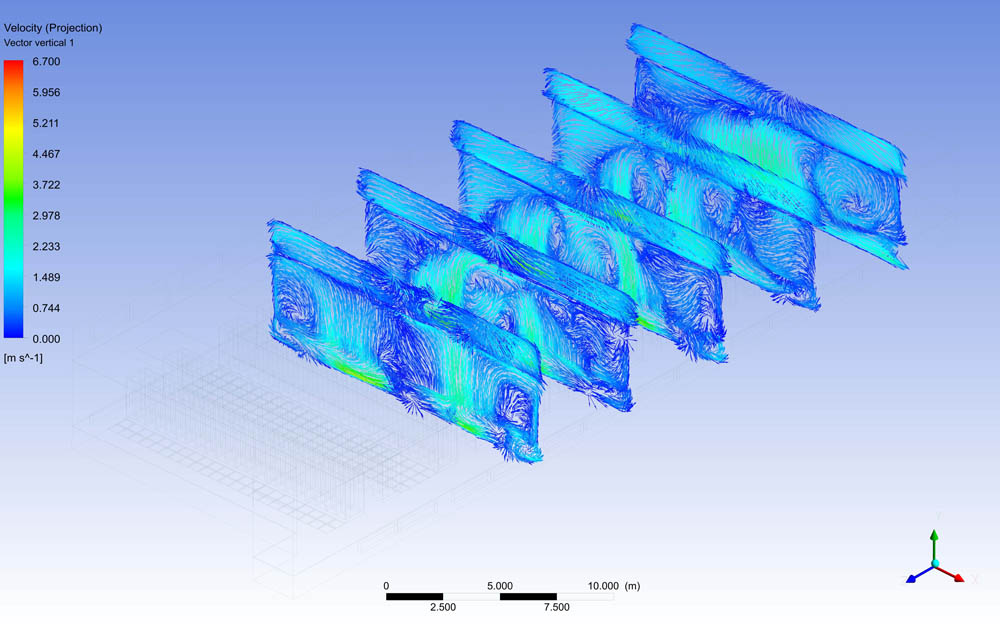

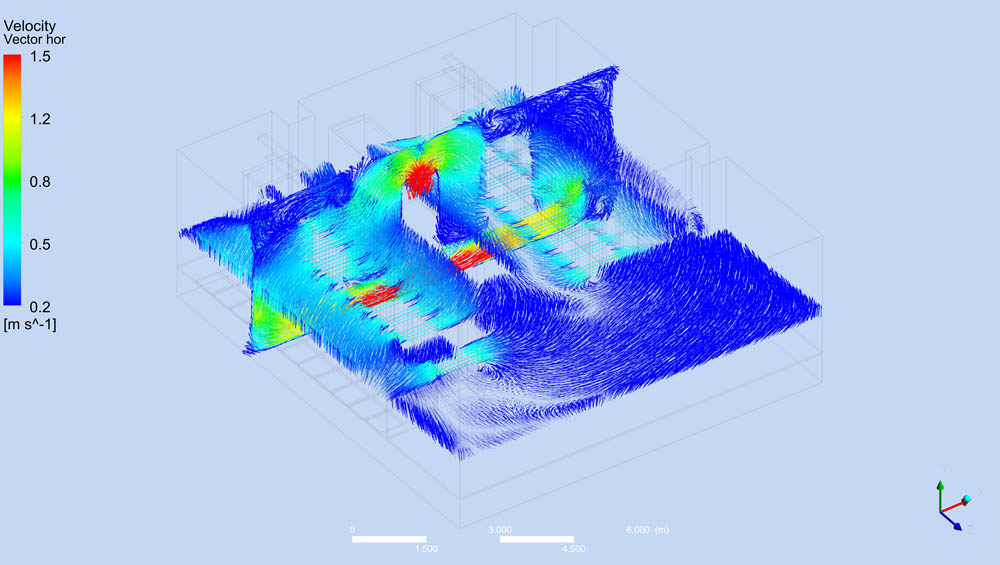

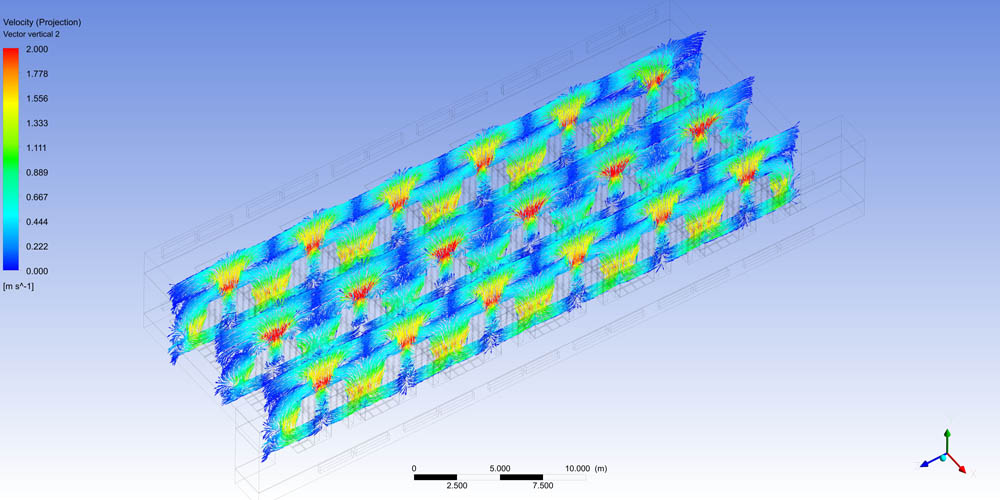

Поскольку заказчик не может спрогнозировать равномерность распределения «тяжёлых» стоек, мы сперва прикидываем общую компоновочную схему помещений, затем строим модель, по которой считаются разные конфигурации зала, и по которой считаем потоки воздуха.

Потом исследуем сами потоки. Вот так это выглядит:

Это важно, потому что могут стоять два соседних ряда, в одном стойки будут 14 кВт, в другом — 2 кВт. Среднее по ним будет восемь, но в одном горячем коридоре будет очень тепло и кондиционеры будут работать на износ, а во втором — будут падать по ошибкам, потому что охлаждать нечего. То есть план размещения ИТ-оборудования хотя бы примерно надо продумывать ещё уже на этапе проектирования инженерных систем и коммуникаций.

И таких нюансов по проекту — десятки.

Вот ещё пример фактора нестабильности — процесс согласования. Любое новое строительство согласовывается много раз в разных инстанциях. Это довольно итеративный процесс. Сроки согласования непредсказуемые.

Исходя из этого в каждом случае необходимо находить решения, чтобы получался компромисс с различными инстанциями по поводу того, что можно, что нельзя делать в том или ином здании и площадке. Образуется целая база инженерных лайфхаков: как удовлетворить требования нескольких стандартов сразу и при этом сохранить эффективность.

В отдельных регионах не всегда можно быстро изменить назначение здания. Часто строят ЦОДы в офисных или бывших «приофисных помещениях» (гаражи, склады). Надо менять назначение на промышленное. Часто оказывается, что изначально заказчик мог не поменять «гараж» на «офис», и приходится проходить всю цепочку целиком. И иногда это означает, что проще выбрать новую площадку, чем получить разрешение на эту.

У госкомпаний в этот процесс добавляется ещё одна особенность. У них очень жёсткие договора и, в частности, сроки по ним. А согласования внутри заказчика, между его департаментами — нерегламентированный по времени процесс.

Потом отпечаток накладывает страх новых технологий. В разных странах мы видим разное отношение к этому вопросу: где-то доверяют подрядчику, но очень жёстко проверяют по техтребованиям все предлагаемые решения, а где-то всё делают «по старинке» и заказчик, и подрядчик.

У нас обычно есть разрыв между тем, что знаем мы как проектировщики, строители и практики, и тем, что помнит заказчик из опыта своего предыдущего ЦОДа. Вот строил он десять лет назад, и всё получилось хорошо. Значит, надо построить точно такой же ЦОД, но побольше. А это не всегда хорошо сейчас.

Новые законодательные аспекты, экологические нормы, технологии — рынок меняется довольно быстро. Я вот часто встречаюсь с тем, что заказчик просто не знает о существовании альтернативы классической связке — статические ИБП + ДГУ. Для них дизель-динамический источник бесперебойного питания (ДДИБП) — чёрный ящик, и они сразу отметают вариант с ним.

Вторая фаза отрицания наступает в момент, когда сравниваются согласования с МЧС, дополнительные помещения, согласование по канализации и так далее. Но если посчитать все плюсы и минусы — уже задаётся база для выбора. Как правило, там деньги из расчёта на пять, десять и 20 лет, и этот язык все понимают отлично.

А ещё из этой проблемы с непониманием технологий растёт следующая. Заказчик не всегда реально оценивает сроки. Это касается не только строительства ЦОДа и инженерки, но и всего ИТ-рынка. Первая причина в том, что рынок развивается. Время на монтажные и пусконаладочные работы, как и сложность этих работ, а соответственно и квалификация привлекаемого персонала, сейчас растёт, но потом эксплуатировать такие системы значительно проще, чем созданные на базе прошлых технологий, — такой вот тренд технологий.

Вторая причина — часто внутри заказчика есть долгосрочная программа развития. И не всегда внутри себя заказчик начинает проект, когда он должен был начаться по программе. Но закончиться-то он должен ровно по ней! Если был год на серверные, а начали со смещением шесть месяцев, то построить их надо за шесть оставшихся месяцев. Внутри компании сроки не двигаются.

И надо что-то выдумывать. А ещё иногда заказчик сокращает их целенаправленно, потому что его опыт показывает, что можно делать быстрее, чем заявлено. Действительно можно. Но в сроках реализации, обычно лежат таможенные формальности, сезонные пики доставки, проблемы с поставками комплектующих на заводах и август. Август для инженерной инфраструктуры вообще мёртвый.

Основные производители кондиционеров всеми заводами уходят в дружный отпуск — в прошлом году это сдвинуло сроки одного из проектов. Ещё часто проекты надо заканчивать до 1 января, и тут уже католическое Рождество накладывает отпечаток. Рождество начинается 21-22 декабря, когда самая горячая пора в РФ по закрытию проектов. Потом уже наши праздники.

Если «повезло» и машина с грузом зашла на таможню 20 декабря, то выйдет 11 января. И эти три недели могут создать проблемы. Сроки доставки оборудования госзаказчикам не меняются: можно легко влететь не по своей вине и создать себе негативную репутацию или вообще улететь в чёрный список. Поэтому в сроках закладывается не минимум, а объективный период.

Или вот процесс производства: восемь недель для кондиционирования и ИБП, 12 недель для ДГУ — это если сборка из частей со склада. А заводы работают не совсем так. Поэтому на старте проектов стараемся проговаривать вехи, к которым будет привезено оборудование. Чтобы у заказчика был пайплайн, чтобы проверять, что и как. Это важно, чтобы руководитель со стороны заказчика знал, что если сегодня не оплатили — он своими руками сдвинул срок проекта на этот день.

Как-то надо было построить небольшой ЦОД за четыре месяца. Фундамент был, капремонта не было. Два машзала по 100 стоек, 1,2 МВт в каждом. Начало работ — в начале декабря. 13 марта закончили. Выйти на работы в начале зимы в конце года не всем подрядчикам удобно и комфортно: в России все готовятся к длительным праздникам и отпускам. У строителей и то и другое — святое.

Мы работаем с теми, кто знает специфику проектов, поэтому гибко относятся к тому, что надо работать в три смены без перерывов в праздники и выходные. Находят людей и начинают работы. Не всегда сразу начинаем, тут вот спустя неделю начали. Лично у меня 31 декабря того года рабочий день закончился в 18:00. А 2 января я стоял с руководителем проекта заказчика на площадке и смотрел на то, как идут работы.

Нет типовых проектов. Обычно в Европе ЦОДы строятся примерно по одному проекту. Сделал один — и можно по всей стране шлёпать. У нас не так. Мы не можем применять типовые проекты на юге и севере. Разная стоимость топлива.

Разные цены на электричество. Разные экологические требования. Разная среднегодовая температура. На севере хорошо работает фрикулинг. Но зато на югах можно поставить солнечные батареи для ЦОДа для снятия пиков нагрузки, на севере же они помогут максимум освещать придомовую территорию.

Ветряк — очень долгое и дорогое согласование, далеко не везде можно поставить и эксплуатировать. Тот, кто инициирует проект по созданию ЦОДа, не всегда тот же, кто эксплуатирует, поэтому для него построить дешевле сейчас бывает важнее снижения стоимости эксплуатации, но потом.

Из недавнего — вендор поставил дизельное оборудование, машины приехали со спецификацией для стран с жарким климатом, то есть для Саудовской Аравии. Машины нужно охлаждать. И вот отличаются они от «нормальных» — радиусом вентилятора. С точки зрения техники — это не минус, но для нас — это плохо, потому что мы должны контейнеры поставлять со стандартным габаритом.

Машины мощные и ровно вписываются в 12-метровый стандартный контейнер. И вот этот вентилятор торчит из габарита. Пришлось просить подрядчиков делать нестандартный контейнер в стандартном габарите: делать выступы, козырьки от осадков, ветра, доступа.

Особо хочу отметить ЦОДы за Уралом. До них огромные расстояния, которые нужно пересекать по отвратительным дорогам, чтобы привезти оборудование. И не всегда оно приезжает целым. Далеко не все вендоры готовы давать поддержку на дальние регионы. У нас есть экспертиза и хорошая инженерная служба, поэтому часто нам аутсорсят такие заказы.

А так для критичных ЦОДов важно знать, что далеко не все готовы подписаться на SLA четыре часа на какой-нибудь объект с полезными ископаемыми. За пределами Москвы, Петербурга, Екатеринбурга и Казани такие SLA вообще звучат как фантастика. А на Крайнем Севере вообще слово SLA приобретает саркастический оттенок.

Следствие — выбор вендоров с широкой сетью сервиса. Часто более дешёвый вендор хуже именно с точки зрения эксплуатации.

Источник: habr.com

Как построить ЦОД и не выкинуть на ветер миллионы рублей

Российский рынок коммерческих дата-центров развивается динамически. В строительство новых площадок вкладывают миллионы рублей, причем интерес к таким проектам все чаще проявляют не только профильные сервис-провайдеры, но и частные инвесторы, которые хотят заработать на перспективном рынке. Также задача строительства in-house ЦОД остается актуальной для многих крупных компаний, особенно с государственным участием. Подтверждает эту динамику и аналитика. «ТМТ Консалтинг» показывают рост объема рынка дата-центров на 10,6% за год и оценивают в 23,6 млрд рублей по итогам 2017. Прогнозируют увидеть такой же уровень роста и в 2018 году.

Возведение и оснащение ЦОД — дорогостоящий проект. Мировая индустрия строительства дата-центров оценивается в несколько десятков миллиардов долларов. Цифры колеблются от $17,15 млрд по данным Orbis Research до $43,7 млрд по данным Research and Markets по итогам 2017 года. В России в сфере строительства дата-центров также вращаются миллиардные бюджеты.

Например, недавно было объявлено, что «Ростелеком» и «Росатом» построят федеральную сеть ЦОД стоимостью 22 млрд рублей в рамках госпрограммы «Цифровая экономика». Строительство дата-центра для крупного предприятия может обойтись в несколько сотен миллионов рублей.

Услуги по строительству дата-центров оказывают множество компаний, но их компетенции разнятся. В действительности среди них мало тех, кто может не только построить ЦОД, но и помочь его грамотно эксплуатировать. Это не самая сильная сторона российских подрядчиков, хотя на Западе такие услуги поставляются в комплексе.

Часто возникает ситуация, когда заказчики со стороны предприятия не могут сформулировать технические требования к будущему ЦОД, поскольку у них нет опыта эксплуатации таких объектов, и полностью полагаются на компетенцию строителей. Те, в свою очередь, выходят из проектов по завершении строительства, а потому никогда не поддерживали работоспособность дата-центров. Это значит, что за миллионы рублей заказчик получает «кота в мешке»: сложный инженерный объект, чья эффективность и работоспособность в будущем остаются под большим вопросом.

Строить или арендовать?

Стоит ли инвестировать в настолько сложный и дорогостоящий проект, когда существуют услуги colocation (размещения оборудования на стороне провайдера) и облачные сервисы? По мере роста бизнеса возникает потребность в расширении потребляемых информационных ресурсах, которые можно либо приобретать как услугу у ИТ-провайдера в коммерческом ЦОДе, либо развивать их как собственный актив. Также, существует опция совмещения обоих подходов в рамках корпоративной стратегии – часть данных и приложений размещается в собственном дата-центре, часть отдается на сторону.

Услуги дата-центров помимо бизнес-сегмента сегодня все чаще востребованы госпредприятиями. Им, а также финансовым и телекоммуникационным компаниям может требоваться надежное хранилище больших массивов данных и другие ИТ-услуги, которые нельзя доверить стороннему провайдеру.

Главное преимущество владения собственным дата-центром — тотальный контроль над данными и сервисами, а также рабочей средой. Поэтому для бизнеса, критически чувствительного к простоям, репутационные и прочие издержки могут перевесить дорогостоящие вложения в собственный ЦОД. Кроме того, владение собственным ЦОД снижает риск потери аренды и позволяет максимально задействовать физическое пространство дата-центра. Для тех, кто делает выбор в пользу строительства, задача состоит в том, чтобы потратить выделенные средства по возможности разумно.

Цена дата-центра

На этапе оценки стоимости строительства дата-центра большинство компаний, которые становятся на этот путь, совершают первую ошибку: делают неверный расчет капитальных затрат и не учитывают сопутствующие расходы. Так, предварительное планирование, проектирование и ввод ЦОД в эксплуатацию могут обойтись еще в 20-25% дополнительно к стоимости строительства.

Если нет готового здания, необходимо учесть стоимость возведения стен. По оценкам Forrester Research, стены дата-центра и физические системы безопасности обойдутся в $200 за квадратный фут ($2152 (около 140 тыс. рублей) за 1 кв. м. К этой сумме требуется добавить стоимость систем обнаружения и пожаротушения, это еще десятки тысяч долларов (от $20 до $60 тыс. в среднем).

Стоит также учесть стоимость получения разрешения на строительство, стоимость установки механического и ИТ-оборудования, приобретения необходимых мощностей электропитания, стоимость прокладки оптоволокна и сетевого подключения объекта.

Эксплуатационные расходы также должны подвергаться тщательной оценке. Например, львиная доля расходов будет приходиться на аренду мощностей. Еще одна затратная статья — оплата работы персонала, обеспечение круглосуточного наблюдения и технического обслуживания, в том числе расходы на медицинские страховки, отпуска, лицензирование и обучение сотрудников. К этому нужно добавить ежегодные расходы на обслуживание объектов инфраструктуры (от 3 до 5% от первоначальной стоимости строительства), а также предусмотреть расходы на ремонт и модернизацию примерно на третий год работы. Эксплуатация может составить до 80% бюджета всего проекта.

И это еще не всё

Если все перечисленное уже кажется достаточно сложной задачей, то напомню, что мы еще даже не подобрались непосредственно к проекту. Возможно, уже на этапе расчета стоимости возникнет здравая идея умерить аппетит и требования к техническим параметрам будущего дата-центра. На самом деле, стадия оценки стоимости и проектирования тесно связаны, потому что между эксплуатационными расходами на 10 и 100 стоек пролегает пропасть. Важно трезво оценить, сколько и какого оборудования нужно конкретному предприятию, чтобы банально не переплачивать за лишние мощности и их жизнеобеспечение.

Самым разумным шагом на этой стадии является привлечение к процессу проектирования третьей стороны — сервис-провайдера, который имеет опыт эксплуатации крупных коммерческих ЦОД уровня Tier Ш и Tier IV. Только компания, нарабатывающая годами такой опыт, может адекватно оценить все возможные технические нюансы работоспособности объекта такой сложности. Технические консультанты помогут сформулировать требования под конкретные бизнес-задачи, не потратить лишнего, а также избежать обратной распространенной ошибки — тотальной экономии на всем. Ориентируясь на дешевые и при этом плохо масштабируемые решения, компании часто упираются в потолок возможностей спроектированной инфраструктуры, и для ее дооснащения «вдруг» требуются затраты, сопоставимые с первоначальными.

Вот перечень лишь основных «узких мест» в процессе построения и эксплуатации ЦОД:

— Грамотно составленное техзадание – сегодня этим чаще всего занимается проектировщик объекта, при таком подходе вся философия будущего дата-центра зависит от специалистов организации, не принимающих участия в управлении дата-центром и в эксплуатации его систем. В будущем это чревато обнаружением множества моментов, которые потребуют серьезной и затратной корректировки.

— Учет региона расположения ЦОД в плане представленности техподдержки вендоров оборудования, наличия качественных подрядчиков, доступности достаточного количества квалифицированных кадров. От этого зависит конфигурация многих систем дата-центра: если нет уверенности в кадровом обеспечении объекта, имеет смысл положиться на мониторинг, определить на самых ранних этапах, какие параметры каких систем и каким типом датчиков отслеживать, потребуется ли управление в режиме реального времени (например, при аварийной ситуации) и т.д.

— Готовить персонал для ЦОД нужно уже на этапе строительства, чтобы за полгода до конца стройки начать работу с линейными инженерами: подготовить подробные инструкций, провести тестирование знаний и навыков для обеспечения бесшовного перехода от стройки к эксплуатации.

— Сдача проекта – тончайшая работа, многокомпонентный процесс, отражающий комплексный характер дата-центра как объекта на стыке инженерии, ИТ, телекома, процессуальных стратегий и множества отраслевых тонкостей. Пусконаладка предполагает испытания нагрузками, превышающими расчетный максимум. Этот процесс должен быть проведен в обязательном порядке, выполнить его грамотно, не поломав

— Эксплуатация ЦОД требует постоянного аудита процессов и документации по отраслевым стандартам, доработки инструкций на все рабочие ситуации. Без опыта подобной работы, управление дата-центром на должном уровне невозможно.

Дьявол в деталях

Рассказать о всех нюансах проектирования и эксплуатации дата-центра в пределах одной колонки невозможно. Просто приведу наглядный пример, насколько опыт и знание рынка важны в этом сложном инженерном процессе. Недавно Linxdatacenter получил предложение использовать динамические источники бесперебойного питания (ИБП).

Это оборудование, которое позволяет поддерживать электропитание дата-центра в случае отключений подачи энергии. Предложенное нам решение от известного мирового вендора было безупречно с точки зрения своих технических возможностей, но в процессе выяснения деталей о поддержке решения, стало понятно, что использовать его просто неблагоразумно, так как вендор не обеспечивает круглосуточный саппорт. Это значит, что в случае сбоев можно было бы столкнуться с непредсказуемым сценарием по восстановлению работоспособности ИБП. Хотя, повторюсь, само решение технически безупречно.

Таких деталей в деле строительства дата-центра сотни, поэтому проектирование и строительство ЦОД собственными силами для компании, которая фокусируется на других продуктах или услугах, фактически лишено смысла.

Делиться компетенцией

Опытные ЦОДостроители сейчас используют накопленную компетенцию и опыт для развития рынка дата-центров в России и повышения качества их строительства. Например, мы в Linxdatacenter уже получаем запросы от крупных российских компаний на оказание консалтинговых услуг в области строительства и эксплуатации ЦОД. Модели такого сотрудничества могут быть разными: от предоставления консалтинга на первоначальном этапе до полного аутсорсинга службы эксплуатации дата-центра усилиями опытных специалистов.

Консалтинг может включать разные составляющие, от написания технического задания, выбора площадки для строительства, расчета работы конкретных инженерных систем, а также подготовки и обучения технического персонала и составления программы пуско-наладочных работ.

Согласно статистике, 40% компаний, которые пережили масштабный сбой на уровне сетевой ИТ-инфраструктуры, уходят из бизнеса в течение 2-х лет. Это мировые данные, и российская действительность пока немного отстает от глобального тренда. Тем не менее, по мере цифровой трансформации всех отраслей, для российских компаний простои и сбои в работе ИТ-инфраструктуры также станут ударять по репутации и конкурентоспособности все больнее.

Источник: www.comnews.ru